Ma infatti per chi ha saltato la gen precedente, la serie 4000 va benissimomi fa piacere per te. :)

io scelsi di saltare la serie 3 perchè non avevo tempo di fare refresh ogni 5 minuti su un sito per trovarla disponibile e non volevo cadere in mano agli scalper.

se devo essere sincero, se quello che ci ha mostrato nvidia è vero, ed è vero, si deve solo capire quanto è vero, per me le schede valgono molto più delle serie 3 che avevano dato aumenti molto marginali rispetto alle 2080Ti senza portare nessuna nuova tecnologia.

prezzo giustificato? certo che no ma meglio una 4090 a 2500€ che una 3090 a 2500€ come se ne erano viste :)

se tu l'hai presa a meno, se l'hai presa a di più, non conta, l'importante è che tu sia soddisfatto.

vale più una 3090 a 2500€ al lancio o una 4090 a 2500€ al lancio?

direi che la risposta non ha senso di essere data.

Installa l'app

Come installare l'app su iOS

Segui il video qui sotto per vedere come installare il nostro sito come web app sulla tua schermata principale.

Nota: Questa funzionalità potrebbe non essere disponibile in alcuni browser.

Pubblicità

Stai usando un browser non aggiornato. Potresti non visualizzare correttamente questo o altri siti web.

Dovreste aggiornare o usare un browser alternativo.

Dovreste aggiornare o usare un browser alternativo.

UFFICIALE Nvidia RTX 4000 (Lovelace)

- Autore discussione crimescene

- Data d'inizio

Pubblicità

BrutPitt

Utente Attivo

- Messaggi

- 1,395

- Reazioni

- 1,427

- Punteggio

- 102

A parte il DLSS 3, parlando delle altre tecnologie a cui si e' fatto riferimento nella presentazione, cio' che chiamano NVIDIA Real Time Denoiser (NDR)

developer.nvidia.com

Non e' una tecnologia esclusiva della serie 4000 (anche se nella presentazione hanno lasciato che si ipotizzasse questo):

developer.nvidia.com

Non e' una tecnologia esclusiva della serie 4000 (anche se nella presentazione hanno lasciato che si ipotizzasse questo):

Infatti e' gia' disponibile anche per tutta la serie RTX, essendo un progetto OpenSource (che gia' seguo da piu' di un anno):

github.com

github.com

Stessa cosa per RTX Direct Illumination (RTXDI)

developer.nvidia.com

developer.nvidia.com

Anch'esso gia' su GitHub da qualche tempo

NVIDIA RTX Kit

Render game assets with AI, create game characters with photo-realistic visuals, and more.

Infatti e' gia' disponibile anche per tutta la serie RTX, essendo un progetto OpenSource (che gia' seguo da piu' di un anno):

GitHub - NVIDIA-RTX/NRD: NVIDIA Real-time Denoising (NRD) library

NVIDIA Real-time Denoising (NRD) library. Contribute to NVIDIA-RTX/NRD development by creating an account on GitHub.

Stessa cosa per RTX Direct Illumination (RTXDI)

NVIDIA RTX Kit

Render game assets with AI, create game characters with photo-realistic visuals, and more.

Anch'esso gia' su GitHub da qualche tempo

Le "reali differenze" le vedremo appunto li'!Poi manca la vera prova su strada sui vari giochi

Inviato dal mio iPhone utilizzando Tapatalk Pro

- Messaggi

- 5,082

- Reazioni

- 4,403

- Punteggio

- 159

Posso assicurarti che non è vero. Il dlss è stato creato con l'unico scopo di reggere il raytracing introdotto da nvidia in ambito gaming molto in anticipo rispetto alla tecnologia. Senza il dlss il raytracing è inutilizzabile anche su una rtx 4090 come è stato mostrato da nvidia stessa, con dlss disattivato i frame erano imbarazzanti considerando che parliamo di una gpu da 2000 euro.se ti inorridisce significa che non lo capisci.

il DLSS serve per i 4K, se usi i monitorini low res a 600Hz ovvio non ti serve :)

Il 4k era possibile già all'epoca della gtx 980ti, ti posso assicurare che il mio amico ci giocava su the witcher 3 in 4k, gta 5 ecc

Anche con la gtx 1080ti si gioca in 4k, in base alla potenza della gpu si va a modificare i settaggi grafici in modo da poter gestire il software a quella risoluzione. Mi sembra banale e scontato dirlo, che ci sono eccezioni come limitazione di vram in alcuni casi o di software estremamente ottimizzati male ( cyberpunk 2077 esempio ).

Il dlss, ripeto, serve solo a gestire il raytracing tanto voluto da nvidia, se disattivo il raytracing posso giocare con la mia rtx 3080 12gb ad oltre 60 fps in 4K nativo su cyberpunk 2077 appena attivo il raytracing in 4k, il gioco gira a 12 fps ed ecco che entra in gioco il dlss.

Comunque vedremo la differenza prestazionale tra una rtx 3080 e una rtx 4080 senza dlss 3.0, voglio proprio vedere questo x2, l'ultima volta che ho visto un x2 o persino superiore è stato dal passaggio della gtx 7800 alla gtx 8800 con un bel 130% in più cioè 2.3x

techsaskia

Utente Èlite

- Messaggi

- 3,280

- Reazioni

- 1,158

- Punteggio

- 133

questi post sono musica per le mie orecchie.A parte il DLSS 3, parlando delle altre tecnologie a cui si e' fatto riferimento nella presentazione, cio' che chiamano NVIDIA Real Time Denoiser (NDR)

Non e' una tecnologia esclusiva della serie 4000 (anche se nella presentazione hanno lasciato che si ipotizzasse questo):

NVIDIA RTX Kit

Render game assets with AI, create game characters with photo-realistic visuals, and more.developer.nvidia.com

Infatti e' gia' disponibile anche per tutta la serie RTX, essendo un progetto OpenSource (che gia' seguo da piu' di un anno):

GitHub - NVIDIA-RTX/NRD: NVIDIA Real-time Denoising (NRD) library

NVIDIA Real-time Denoising (NRD) library. Contribute to NVIDIA-RTX/NRD development by creating an account on GitHub.github.com

Stessa cosa per RTX Direct Illumination (RTXDI)

NVIDIA RTX Kit

Render game assets with AI, create game characters with photo-realistic visuals, and more.developer.nvidia.com

Anch'esso gia' su GitHub da qualche tempo

Le "reali differenze" le vedremo appunto li'!

vedo che anche a te JetBrains ha regalato la suite per via dei tuoi progetti OpenSource.

fa sempre piacere ed è bello sapere che qui sul forum ci sia una persona così competente in materia.

--- i due messaggi sono stati uniti ---

Posso assicurarti che non è vero. Il dlss è stato creato con l'unico scopo di reggere il raytracing introdotto da nvidia in ambito gaming molto in anticipo rispetto alla tecnologia. Senza il dlss il raytracing è inutilizzabile anche su una rtx 4090 come è stato mostrato da nvidia stessa, con dlss disattivato i frame erano imbarazzanti considerando che parliamo di una gpu da 2000 euro.

Il 4k era possibile già all'epoca della gtx 980ti, ti posso assicurare che il mio amico ci giocava su the witcher 3 in 4k, gta 5 ecc

Anche con la gtx 1080ti si gioca in 4k, in base alla potenza della gpu si va a modificare i settaggi grafici in modo da poter gestire il software a quella risoluzione. Mi sembra banale e scontato dirlo, che ci sono eccezioni come limitazione di vram in alcuni casi o di software estremamente ottimizzati male ( cyberpunk 2077 esempio ).

Il dlss, ripeto, serve solo a gestire il raytracing tanto voluto da nvidia, se disattivo il raytracing posso giocare con la mia rtx 3080 12gb ad oltre 60 fps in 4K nativo su cyberpunk 2077 appena attivo il raytracing in 4k, il gioco gira a 12 fps ed ecco che entra in gioco il dlss.

Comunque vedremo la differenza prestazionale tra una rtx 3080 e una rtx 4080 senza dlss 3.0, voglio proprio vedere questo x2, l'ultima volta che ho visto un x2 o persino superiore è stato dal passaggio della gtx 7800 alla gtx 8800 con un bel 130% in più cioè 2.3x

Per giocare in 4K con la 980Ti a TW3 maxxato ci voleva lo SLI di Ti, te lo dice uno che aveva lo SLI di 980Ti e il monitor 4K e che ha platinato TW3. :)

il discorso mi sembra senza senso per cui per me la possiamo chiudere qui, se non ti interessa il RT buon per te,

risparmierai sulle schede, in questo caso però hai pure sbagliato scheda, ti potevi prendere una AMD che spendevi meno e nel raster va più forte :)

--- i due messaggi sono stati uniti ---

A chi non interessa il ray tracing e non interessa il dlss siamo nell'ordine di un +50% circa.

Poca roba.

Mi domando però perchè però comprare una GPU Nvidia RTX se non interessa il RT e non interessa il DLSS.

Ultima modifica:

jesse83

Utente Èlite

- Messaggi

- 6,314

- Reazioni

- 5,096

- Punteggio

- 176

Perdonatemi ma mi sembra che la cosa stia degenerando un pochino troppo...dopo i fanboy Nvidia vs Amd adesso ci sono anche i fanboy del raytracing? mi sembra eccessivo dai...

Quello che ha fatto vedere Fonzie nella sua presentazione è sicuramente la verità (anche perchè se non lo fosse fallirebbe dopo 2 minuti), ma ovviamente si applica esclusivamente alla 4090 con dlss su prestazioni e RT attivo. é lì da vedere. è mostruoso l'incremento di prestazioni, giustamente spinto sulle loro tecnologie di punta. E se vediamo il prezzo annunciato, è anche notevolmente migliore di quando uscì la 3090, non c'è storia.

Ma siamo sempre lì: a chi serve una 4090? come non c'è bisogno di una 3090 per giocare, non ci sarà bisogno di una 4090 neanche per i futuri giochi. é una scheda pensata per chi lavora, e l'ha fatto vedere: si possono creare cose incredibili, io che lavoro con la modellazione 3D tutti i giorni farei carte false per averla.

Ma per il resto, forse l'unica con un altro grosso incremento rispetto la gen precedente sarà la 4080 16GB, ma le altre secondo me sarà il solito 30/35% intragen. Stiamo a vedere recensioni serie comunque.

Tuttavia è stato abbastanza deludente non vedere almeno una 4070, giusto per farsi un'idea se stavolta abbiano pensato alla fascia medio-bassa.

EDIT: dimenticavo...come sempre se uno ha i soldi che gli avanzano fa solo che bene a prendere una 4090, sia chiaro altrimenti posso sempre lasciare il mio iban

altrimenti posso sempre lasciare il mio iban

Quello che ha fatto vedere Fonzie nella sua presentazione è sicuramente la verità (anche perchè se non lo fosse fallirebbe dopo 2 minuti), ma ovviamente si applica esclusivamente alla 4090 con dlss su prestazioni e RT attivo. é lì da vedere. è mostruoso l'incremento di prestazioni, giustamente spinto sulle loro tecnologie di punta. E se vediamo il prezzo annunciato, è anche notevolmente migliore di quando uscì la 3090, non c'è storia.

Ma siamo sempre lì: a chi serve una 4090? come non c'è bisogno di una 3090 per giocare, non ci sarà bisogno di una 4090 neanche per i futuri giochi. é una scheda pensata per chi lavora, e l'ha fatto vedere: si possono creare cose incredibili, io che lavoro con la modellazione 3D tutti i giorni farei carte false per averla.

Ma per il resto, forse l'unica con un altro grosso incremento rispetto la gen precedente sarà la 4080 16GB, ma le altre secondo me sarà il solito 30/35% intragen. Stiamo a vedere recensioni serie comunque.

Tuttavia è stato abbastanza deludente non vedere almeno una 4070, giusto per farsi un'idea se stavolta abbiano pensato alla fascia medio-bassa.

EDIT: dimenticavo...come sempre se uno ha i soldi che gli avanzano fa solo che bene a prendere una 4090, sia chiaro

Ultima modifica:

pribolo

Utente Èlite

- Messaggi

- 38,481

- Reazioni

- 13,888

- Punteggio

- 253

Come prima impressione, prezzi alti, molto alti soprattutto per le due 4080, perchè la 4090 ci sta che costi una fucilata, è sempre stato così per la top di gamma. Ma le due 4080, ben più umili della sorella maggiore, oltre i 1000 sono care.

Tra l'altro, vorrei conoscere chi ha avuto l'idea di lanciare due prodotti completamente diversi, 4080 16GB e 4080 12GB, che avranno ovviamente prestazioni diverse, con lo stesso nome, giusto per confondere le idee...

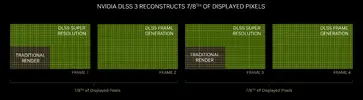

Comunque, la cosa più interessante di cui si è parlato oggi è sicuramente il DLSS 3.0.

IL DLSS 3.0 non è una versione ottimizzata del DLSS 2.0 ed è assolutamente plausibile (per non dire certo) che non fosse possibile implementarlo nelle vecchie schede, non in questa forma per lo meno.

Qui è spiegato piuttosto bene e in modo comprensibile anche ai non specialisti del settore, tipo me, come lavora: https://www.nvidia.com/en-us/geforce/news/dlss3-ai-powered-neural-graphics-innovations/

E questa è l'immagine chiave per capirlo:

In pratica, oltre al consueto utilizzo dell'AI per upscalare l'immagine, quindi portarla a una risoluzione più alta, una tecnica simile viene utilizzata per interpolare i frame.

Quindi il DLSS non è più solamente un avanzato algoritmo di upscaling, ma anche di interpolazione. Tutto ciò è reso possibile dall'analisi dei vettori di movimento forniti dal motore del gioco, ma anche dell'utilizzo dell'optical flow accelerator (un nuovo hardware specializzato, a quanto ho capito) per stimare il movimento di ogni pixel a schermo.

Ciò si rende necessario perchè i vettori movimento tengono conto solo del movimento della geometria della scena, non degli effetti aggiunti successivamente, tipo i particellari e l'illuminazione (le ombre in sostanza): senza la ricostruzione operata dall'optical flow acceleration ad esempio le ombre non sarebbe ricostruite correttamente.

Intendiamoci, tutto ciò non è un male e personalmente sono curioso di vederlo all'opera, ma rende il numerino degli fps, su cui sono basate le slide Nvidia per altro, piuttosto forviante.

Ciò che sarà importante verificare è come migliora la fluidità percepita attivando questa nuova modalità DLSS. Perchè è chiaro che gli fps conteggiati vengono praticamente raddoppiati: tra l'altro, essendo un lavoro eseguito in post processing dalla GPU stessa, il frame rate viene raddoppiato anche in situazioni CPU Limited.

Non è immediatamente chiaro, ma lo è se ci si pensa un secondo, che ciò non è paragonabile ad avere il doppio del framerate ottenuto tramite una modalità di rendering tradizonale, se non altro perchè la latenza, intesa come tempo trascorso tra gli input del giocatore e l'effettivo recepimento del comando, non diminuisce proporzionalmente.

Ma anche a livello visivo ci sarà da verificare che benefici porta, perchè non mi aspetto che i frame ricostruiti riescano ad essere perfetti in tutto e per tutto.

Ovviamente, per valutare correttamente questi aspetti, il nuovo DLSS andrà provato su scene in movimento, non su scene statiche: ciò era valido anche per il DLSS 2.0 o l'FSR 2.0 (in generale per qualsiasi upscaling temporale), ma ora diventa veramente imprescindibile. A riscotruire una scena statica (o quasi) interpolando sarei buono pure io....

Tra l'altro, vorrei conoscere chi ha avuto l'idea di lanciare due prodotti completamente diversi, 4080 16GB e 4080 12GB, che avranno ovviamente prestazioni diverse, con lo stesso nome, giusto per confondere le idee...

Comunque, la cosa più interessante di cui si è parlato oggi è sicuramente il DLSS 3.0.

IL DLSS 3.0 non è una versione ottimizzata del DLSS 2.0 ed è assolutamente plausibile (per non dire certo) che non fosse possibile implementarlo nelle vecchie schede, non in questa forma per lo meno.

Qui è spiegato piuttosto bene e in modo comprensibile anche ai non specialisti del settore, tipo me, come lavora: https://www.nvidia.com/en-us/geforce/news/dlss3-ai-powered-neural-graphics-innovations/

E questa è l'immagine chiave per capirlo:

In pratica, oltre al consueto utilizzo dell'AI per upscalare l'immagine, quindi portarla a una risoluzione più alta, una tecnica simile viene utilizzata per interpolare i frame.

Quindi il DLSS non è più solamente un avanzato algoritmo di upscaling, ma anche di interpolazione. Tutto ciò è reso possibile dall'analisi dei vettori di movimento forniti dal motore del gioco, ma anche dell'utilizzo dell'optical flow accelerator (un nuovo hardware specializzato, a quanto ho capito) per stimare il movimento di ogni pixel a schermo.

Ciò si rende necessario perchè i vettori movimento tengono conto solo del movimento della geometria della scena, non degli effetti aggiunti successivamente, tipo i particellari e l'illuminazione (le ombre in sostanza): senza la ricostruzione operata dall'optical flow acceleration ad esempio le ombre non sarebbe ricostruite correttamente.

Intendiamoci, tutto ciò non è un male e personalmente sono curioso di vederlo all'opera, ma rende il numerino degli fps, su cui sono basate le slide Nvidia per altro, piuttosto forviante.

Ciò che sarà importante verificare è come migliora la fluidità percepita attivando questa nuova modalità DLSS. Perchè è chiaro che gli fps conteggiati vengono praticamente raddoppiati: tra l'altro, essendo un lavoro eseguito in post processing dalla GPU stessa, il frame rate viene raddoppiato anche in situazioni CPU Limited.

Non è immediatamente chiaro, ma lo è se ci si pensa un secondo, che ciò non è paragonabile ad avere il doppio del framerate ottenuto tramite una modalità di rendering tradizonale, se non altro perchè la latenza, intesa come tempo trascorso tra gli input del giocatore e l'effettivo recepimento del comando, non diminuisce proporzionalmente.

Ma anche a livello visivo ci sarà da verificare che benefici porta, perchè non mi aspetto che i frame ricostruiti riescano ad essere perfetti in tutto e per tutto.

Ovviamente, per valutare correttamente questi aspetti, il nuovo DLSS andrà provato su scene in movimento, non su scene statiche: ciò era valido anche per il DLSS 2.0 o l'FSR 2.0 (in generale per qualsiasi upscaling temporale), ma ora diventa veramente imprescindibile. A riscotruire una scena statica (o quasi) interpolando sarei buono pure io....

Ultima modifica:

- Messaggi

- 5,082

- Reazioni

- 4,403

- Punteggio

- 159

A me sembri il classico credulone che crede a tutto quello che gli viene detto o mostrato. Ti ricordo che alla presentazione delle rtx 3000, fonzie mostrò questi grafici che si rivelarono falsi. La rtx 3080 doveva essere x2 rispetto alla rtx 2080 ma in realtà è un 65/68% più veloce che per carità è tanto ma non è x2. Sempre nella stessa presentazione veniva detto che le prestazioni con raytracing attivo sarebbero aumentate di un 1.7x, falso anche questo. Tanti canali seri mostrarono che la differenza era minima. Potrei elencarti anche altre cavolate che sono state dette in questi anni ma mi sembri un caso perso.questi post sono musica per le mie orecchie.

vedo che anche a te JetBrains ha regalato la suite per via dei tuoi progetti OpenSource.

fa sempre piacere ed è bello sapere che qui sul forum ci sia una persona così competente in materia.

--- i due messaggi sono stati uniti ---

Per giocare in 4K con la 980Ti a TW3 maxxato ci voleva lo SLI di Ti, te lo dice uno che aveva lo SLI di 980Ti e il monitor 4K e che ha platinato TW3. :)

il discorso mi sembra senza senso per cui per me la possiamo chiudere qui, se non ti interessa il RT buon per te,

risparmierai sulle schede, in questo caso però hai pure sbagliato scheda, ti potevi prendere una AMD che spendevi meno e nel raster va più forte :)

--- i due messaggi sono stati uniti ---

Visualizza allegato 441831

A chi non interessa il ray tracing e non interessa il dlss siamo nell'ordine di un +50% circa.

Poca roba.

Mi domando però perchè però comprare una GPU Nvidia RTX se non interessa il RT e non interessa il DLSS.

Per tua informazione io uso il raytracing e penso sia una straordinaria tecnologia nonostante sia troppo prematura e utilizzo anche il dlss in 1440p quando utilizzo il raytracing e penso che sia una tecnologia incredibile soprattutto per aiutare la gestione del raytracing ( non di certo per la risoluzione ), infine non ho sbagliato gpu, nonostante nvidia mi faccia schifo come azienda, preferisco di gran lunga i loro prodotti per tecnologie e supporto driver, compratela te una gpu amd.

Ultima modifica:

techsaskia

Utente Èlite

- Messaggi

- 3,280

- Reazioni

- 1,158

- Punteggio

- 133

BrutPitt

Utente Attivo

- Messaggi

- 1,395

- Reazioni

- 1,427

- Punteggio

- 102

Ecco bisogna capire cosa sia questo "optical flow accelerator" o "Optical Multi-Frame Generation"... ed attualmente mancano specifiche a riguardo (anche lato sviluppatore: NVidia dice che saranno disponibili "entro" il 12 Ottobre, assieme agli SDK per il DLSS 3)Comunque, la cosa più interessante di cui si è parlato oggi è sicuramente il DLSS 3.0.

IL DLSS 3.0 non è una versione ottimizzata del DLSS 2.0 ed è assolutamente plausibile (per non dire certo) che non fosse possibile implementarlo nelle vecchie schede, non in questa forma per lo meno.

....

Quindi il DLSS non è più solamente un avanzato algoritmo di upscaling, ma anche di interpolazione. Tutto ciò è reso possibile dall'analisi dei vettori di movimento forniti dal motore del gioco, ma anche dell'utilizzo dell'optical flow accelerator (un nuovo hardware specializzato, a quanto ho capito) per stimare il movimento di ogni pixel a schermo.

Anche io mi ero convinto (e lo avevo scritto!) che potesse essere un nuovo "hardware" specializzato e che quindi funzionasse solo su serie 4000.

Adesso pero', man mano che leggo, mi sto ricredendo ed inizio a penare che possano anche essere dei moduli "software", librerie specializzate... cosi' come e' gia' per il Rendering Denoise (NRD) o la Direct Illumination (RTXDI).

E che quindi il DLSS 3 possa essere disponibile (funzionare) anche sulla serie 3000.

Questa pero' NON e' una buona notizia, in quanto le prestazioni che hanno riportato durante la presentazione non se le sono di certo inventate.

Quindi anche se il DLSS3 potra' essere compatibie con la serie 3000, la serie 4000 avra' un'ottimizzazzione decisamente superiore (dovuto alla nuova generazione dei TensorCores), e forse anche un'accelerazione hardware dedicata (totale/parziale), per questa nuova tecnologia (fino a 4X, come dicono le slides).

Cosi' come e' probabile che l'RTX 3.0 influenzi notevolmente anche le performance di NRD e RTXDI (che sicuramente funzionano gia' sulla serie 3000).

Anzi si potrebbe ipotizzare che NVidia abbia progettato/sviluppato l'RTX 3.0 proprio per accelerare via hardware questi "moduli software" che riteneva essenziali per il RayTracing.

Purtroppo, pero', finche' non esce qualcosa di concreto sul lato documentazione... si possono fare solo congetture.

Ultima modifica:

BrutPitt

Utente Attivo

- Messaggi

- 1,395

- Reazioni

- 1,427

- Punteggio

- 102

Ho visto che anche a te JetBrains ha fatto lo stesso regalo... anche tu, da oggi, hai un nuovo follower.questi post sono musica per le mie orecchie.

vedo che anche a te JetBrains ha regalato la suite per via dei tuoi progetti OpenSource.

Son riuscito solo adesso, a quest'ora, ad andare su github a vedere il tuo profilo (compliemnti anche a te!)... da oggi pomeriggio mi sono letteralmente perso nelle varie analisi della presentazione di NVidia.

Ti ringrazio!fa sempre piacere ed è bello sapere che qui sul forum ci sia una persona così competente in materia.

Ma anche a me tocca leggere tra le righe di cio' che hanno "commercialmente" presentato... fare supposizioni... e magari anche sbagliarle.

- Messaggi

- 26,927

- Reazioni

- 14,675

- Punteggio

- 244

Aggiungerei che è immorale anche vendere schede da 1500 euro per giocare… e forse anche 1000 euro.Poi diciamo le cose come stanno, non si possono spendere 2000-2500€ per intrattenimento videoludico, c’è un limite a tutto…….stiamo parlando di hardware per giocare….

P.S. i prezzi sono stragonfiati per invogliare a prendere le 3000 invendute che sono rimaste sul groppone di giacchetta

Inviato dal mio iPhone utilizzando Tapatalk Pro

Ed è irresponsabile produrre hardware che consuma 450/550 W, da associare a CPU da 250W in questo momento storico.

Ma la mungitura della clientela è prioritaria rispetto all’etica, in casa di queste multinazionali (Nvidia in primis), come dimostrato con la vergogna sul mining.

Il DLSS 3.0 riservato alla Serie 40 è l’ennesima porcata di Nvidia. Decisione fatta apposta per vendere il nuovo prodotto (mentre Intel ed AMD cercano di allargare la base delle loro tecnologie a tutti).

Naturalmente prima di giudicare quei “4X” attendo le recensioni. Per quanto sia affascinato dall’idea di una 4080 che vada il triplo della mia 3080, io NON CREDO AD UNA PAROLA del CEO di Nvidia, neppure una singola parola.

Sono quindi curioso di vedere se il gioco che oggi mi va a 90 FPS schizzerà magicamente a 240 FPS oppure se parliamo di un grafico manipolato ad arte dove l’applicazione del DLSS 3.0, negata sulla 3080, è il motivo di questo gap.

Dopo le prime prove approfondite dei “soliti noti” (Techpowerup e Guru3D soprattutto) deiderò se e cosa acquistare.

- Messaggi

- 26,927

- Reazioni

- 14,675

- Punteggio

- 244

Un monitorino low res proprioP.S. Ho un Predator X34GS 3440x1440p 180Hz

Inviato dal mio iPhone utilizzando Tapatalk Pro

Ma come fai a parlare di previsioni confermate o smentite se non abbiamo ancora un SINGOLO BENCHMARK indipendente che ci dica come vanno queste nuoce schede ?Io ho acquistato una 3090 proprio per non comprare queste... anche una 3080ti. Potrei venderle entrambe per comprare una 4000, ma no grazie. Le mie previsioni sono state in parte confermate..

vale più una 3090 a 2500€ al lancio o una 4090 a 2500€ al lancio?

direi che la risposta non ha senso di essere data.

Direi che la domanda non ha senso.

Intanto perché la 3090 al lancio costava 1600/1700 euro, non 2500, e poi parliamo di 2 anni fa.

Ecco questo grafico mi fa un pò paura, in questa parte soprattutto.questi post sono musica per le mie orecchie.

vedo che anche a te JetBrains ha regalato la suite per via dei tuoi progetti OpenSource.

fa sempre piacere ed è bello sapere che qui sul forum ci sia una persona così competente in materia.

--- i due messaggi sono stati uniti ---

Per giocare in 4K con la 980Ti a TW3 maxxato ci voleva lo SLI di Ti, te lo dice uno che aveva lo SLI di 980Ti e il monitor 4K e che ha platinato TW3. :)

il discorso mi sembra senza senso per cui per me la possiamo chiudere qui, se non ti interessa il RT buon per te,

risparmierai sulle schede, in questo caso però hai pure sbagliato scheda, ti potevi prendere una AMD che spendevi meno e nel raster va più forte :)

--- i due messaggi sono stati uniti ---

Visualizza allegato 441831

A chi non interessa il ray tracing e non interessa il dlss siamo nell'ordine di un +50% circa.

Poca roba.

Mi domando però perchè però comprare una GPU Nvidia RTX se non interessa il RT e non interessa il DLSS.

Senza DLSS 3.0 e giochi ottimizzati su misura la differenza gen-to-gen sembra modesta, con la 4080 12 GB che in un paio di titoli va meno di una 3090Ti. E teniamo conto che i 4 titoli messi in croce che hanno usato qui saranno stati scelti “ad hoc” per essere il caso migliore per Nvidia eh.

A questo punto servono proprio le prove indipendenti.

- Messaggi

- 26,927

- Reazioni

- 14,675

- Punteggio

- 244

techsaskia

Utente Èlite

- Messaggi

- 3,280

- Reazioni

- 1,158

- Punteggio

- 133

Sul discorso della moralità non sono d'accordo. Certo è immorale comprare una scheda da 1500€ se non puoi portare tuo figlio dal dentista perché sei sotto con il fido.Aggiungerei che è immorale anche vendere schede da 1500 euro per giocare… e forse anche 1000 euro.

Ed è irresponsabile produrre hardware che consuma 450/550 W, da associare a CPU da 250W in questo momento storico.

Ma la mungitura della clientela è prioritaria rispetto all’etica, in casa di queste multinazionali (Nvidia in primis), come dimostrato con la vergogna sul mining.

Il DLSS 3.0 riservato alla Serie 40 è l’ennesima porcata di Nvidia. Decisione fatta apposta per vendere il nuovo prodotto (mentre Intel ed AMD cercano di allargare la base delle loro tecnologie a tutti).

Naturalmente prima di giudicare quei “4X” attendo le recensioni. Per quanto sia affascinato dall’idea di una 4080 che vada il triplo della mia 3080, io NON CREDO AD UNA PAROLA del CEO di Nvidia, neppure una singola parola.

Sono quindi curioso di vedere se il gioco che oggi mi va a 90 FPS schizzerà magicamente a 240 FPS oppure se parliamo di un grafico manipolato ad arte dove l’applicazione del DLSS 3.0, negata sulla 3080, è il motivo di questo gap.

Dopo le prime prove approfondite dei “soliti noti” (Techpowerup e Guru3D soprattutto) deiderò se e cosa acquistare.

1500€ in se non sono più di quanto costava uno SLI di qualche anno fa.

Ci sono persone che per il divertimento spendono cifre folli anche solo per una giornata magari per cose che ai produttori costano pochissimo.

Diciamo che una GPU dura qualche anno e ha dei costi di sviluppo mastodontici, io non la vedo una cifra così esagerata.

Cmq ricordiamoci che nessuno ci costringe a comprare e che non parliamo di beni di prima necessità, quindi rilasserei un po' il discorso.

Basta non comprare se non piace o se costa troppo.

Lo avevo ipotizzatoQuello che in pochi hanno notato è la slide in cui Nvidia mostra chiaramente che al momento la serie 30 non va in pensione ma resta per il mercato “mainstream”.

Quindi il taglio di prezzo è servito come ipotizzato a spostare 3060, 3070 e 3080 un gradino sotto.

Visualizza allegato 441844

Pubblicità

Pubblicità