Er Barabba

Utente Èlite

- Messaggi

- 6,692

- Reazioni

- 2,757

- Punteggio

- 173

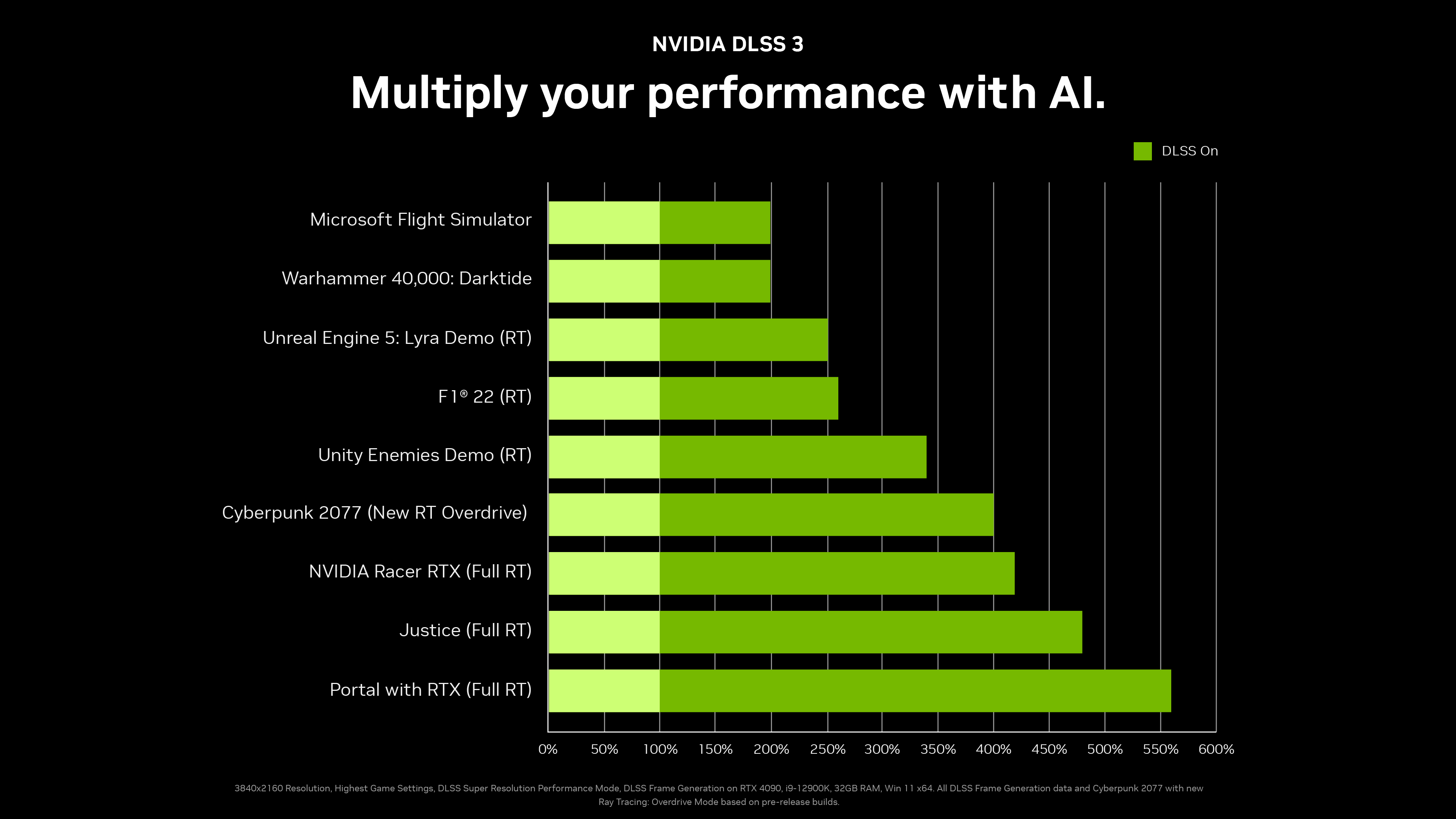

L'hanno fatto vedere... CP2077 in 4K a 130 fpsOnestamente solo un incompetente potrebbe aspettarsi un aumento prestazionale di 3 volte con anche il RT attivo.

Anzi onestamente credo molto poco a questo grafico per un motivo: non conosco cpu che possa star dietro a questo aumento prestazionale della scheda video.