Installa l'app

Come installare l'app su iOS

Segui il video qui sotto per vedere come installare il nostro sito come web app sulla tua schermata principale.

Nota: Questa funzionalità potrebbe non essere disponibile in alcuni browser.

Pubblicità

Stai usando un browser non aggiornato. Potresti non visualizzare correttamente questo o altri siti web.

Dovreste aggiornare o usare un browser alternativo.

Dovreste aggiornare o usare un browser alternativo.

UFFICIALE Intel Alder Lake (Gen 12)

- Autore discussione pribolo

- Data d'inizio

Pubblicità

techsaskia

Utente Èlite

- Messaggi

- 3,279

- Reazioni

- 1,158

- Punteggio

- 133

il mercato delle GPU ormai è un mercato che non mi interessa più.

voi sapete che quando si parla di hardware non sono proprio attento al centesimo ma le GPU ormai hanno raggiunto dei prezzi idioti ed ingiustificabili per me.

la serie 3 ha davvero toccato il fondo dello scandalo raddoppiando i prezzi di vendita a fronte di un risibile aumento di performance rispetto alla precedente generazione e senza portare nessuna nuova features.

dubito che ci riprenderemo mai da questa situazione purtroppo, ormai hanno visto che di polli che comprano GPU a prezzi folli ce ne sono a palate.

voi sapete che quando si parla di hardware non sono proprio attento al centesimo ma le GPU ormai hanno raggiunto dei prezzi idioti ed ingiustificabili per me.

la serie 3 ha davvero toccato il fondo dello scandalo raddoppiando i prezzi di vendita a fronte di un risibile aumento di performance rispetto alla precedente generazione e senza portare nessuna nuova features.

dubito che ci riprenderemo mai da questa situazione purtroppo, ormai hanno visto che di polli che comprano GPU a prezzi folli ce ne sono a palate.

- Messaggi

- 26,927

- Reazioni

- 14,675

- Punteggio

- 244

il mercato delle GPU ormai è un mercato che non mi interessa più.

voi sapete che quando si parla di hardware non sono proprio attento al centesimo ma le GPU ormai hanno raggiunto dei prezzi idioti ed ingiustificabili per me.

sono scesi ora, dai.

Restano alti ma non totalmente assurdi come qualche mese fa.

Guarda ad esempio una 6600XT: è una scheda che se non sei un gamer accanito ti permette qualunque cosa fino al 1440P e trovi sui 450 euro.

Una cifra accettabile per me.

la serie 3 ha davvero toccato il fondo dello scandalo raddoppiando i prezzi di vendita a fronte di un risibile aumento di performance rispetto alla precedente generazione e senza portare nessuna nuova features.

beh risibile aumento di performance non direi proprio: una 3070 Ti va meglio della 2080 Ti ad un prezzo che nonostante l'aumento folle resta inferiore di tanto (oggi sugli 800/850 euro la prendi, la 2080 Ti costava 1400 euro).

Una 3080 costa un rene ma offre prestazioni enormemente superiori alla serie precedente.

Nuove features ? forse no, ma il RT è diventato decisamente più fruibile.

non è solo questione di speculazione. Le schede costano di più da produrre e da distribuire, e questo è innegabile. Certo altrettanto innegabile è che si sono accorti che anche vendendo a 3 volte il prezzo di listino, vendevano tutto comunque...dubito che ci riprenderemo mai da questa situazione purtroppo, ormai hanno visto che di polli che comprano GPU a prezzi folli ce ne sono a palate.

techsaskia

Utente Èlite

- Messaggi

- 3,279

- Reazioni

- 1,158

- Punteggio

- 133

sono scesi ora, dai.

Restano alti ma non totalmente assurdi come qualche mese fa.

Guarda ad esempio una 6600XT: è una scheda che se non sei un gamer accanito ti permette qualunque cosa fino al 1440P e trovi sui 450 euro.

Una cifra accettabile per me.

beh risibile aumento di performance non direi proprio: una 3070 Ti va meglio della 2080 Ti ad un prezzo che nonostante l'aumento folle resta inferiore di tanto (oggi sugli 800/850 euro la prendi, la 2080 Ti costava 1400 euro).

Una 3080 costa un rene ma offre prestazioni enormemente superiori alla serie precedente.

Nuove features ? forse no, ma il RT è diventato decisamente più fruibile.

non è solo questione di speculazione. Le schede costano di più da produrre e da distribuire, e questo è innegabile. Certo altrettanto innegabile è che si sono accorti che anche vendendo a 3 volte il prezzo di listino, vendevano tutto comunque...

max cerchiamo però di rimanere sul pianeta terra.

la 3070Ti è una scheda da 8GB, io nel 2022 una scheda da 8GB non la comprerei nemmeno alla metà del prezzo e poi è una scheda che ha quasi 4 anni di meno della 2080Ti.

che paragone stai facendo?

una scheda con molta meno RAM (parlo di molto perchè la differenza tra 8GB e 11GB è molto importante e lo sarà sempre di più in futuro) che va poco più di una scheda di 4 anni prima senza portare una singola nuova features?

io non avallerei simili comportamenti... è proprio vero che Jensen è un genio, sta cambiando la mente anche degli appassionati.

è passato dal vendere una 980Ti a 800€ al vendere una top di gamma a 2000€ e farlo sembrare quasi un affare.

tant'è che ora un obrobrio come la 3070Ti a 800€ pare pure un affare.

vuoi giustificare una simile monnezza?

prima in 4 anni c'erano aumenti di performance, supporto a nuove librerie grafiche, nuove feaures, qua che c'è?

meno VRAM?

PS: siamo ampiamente OT scusate. la chiudo qui.

- Messaggi

- 5,229

- Reazioni

- 4,013

- Punteggio

- 168

Si certo, finché nvidia continua a produrre schede da 400 e passa watt che necessitano di alimentazioni e raffreddamenti da centrale nucleare è abbastanza ovvio ?Le schede costano di più da produrre e da distribuire, e questo è innegabile

E con le 4000 ci sarà da ridere (o da piangere per chi le comprerà).

Tornando in tema intel, dimentichi l'imminente uscita delle schede intel.dubito che ci riprenderemo mai da questa situazione purtroppo

Intel probabilmente sarà anche disposta a comprarsi fette di mercato inizialmente, che vorrebbe dire vendere le schede anche in leggera perdita.

Possono permetterselo e se serve lo faranno vedrai.

L unica cosa dove intel non potrà incidere al momento sarà la fascia alta (e infatti tremo a pensare al prezzo della prossima top amd multidie) ma sulla fascia media e bassa dovrebbe portare un bel po' di sana concorrenza.

- Messaggi

- 26,927

- Reazioni

- 14,675

- Punteggio

- 244

8 GB non significa nulla.max cerchiamo però di rimanere sul pianeta terra.

la 3070Ti è una scheda da 8GB, io nel 2022 una scheda da 8GB non la comprerei nemmeno alla metà del prezzo e poi è una scheda che ha quasi 4 anni di meno della 2080Ti.

che paragone stai facendo?

una scheda con molta meno RAM (parlo di molto perchè la differenza tra 8GB e 11GB è molto importante e lo sarà sempre di più in futuro) che va poco più di una scheda di 4 anni prima senza portare una singola nuova features?

io non avallerei simili comportamenti... è proprio vero che Jensen è un genio, sta cambiando la mente anche degli appassionati.

è passato dal vendere una 980Ti a 800€ al vendere una top di gamma a 2000€ e farlo sembrare quasi un affare.

tant'è che ora un obrobrio come la 3070Ti a 800€ pare pure un affare.

vuoi giustificare una simile monnezza?

prima in 4 anni c'erano aumenti di performance, supporto a nuove librerie grafiche, nuove feaures, qua che c'è?

meno VRAM?

PS: siamo ampiamente OT scusate. la chiudo qui.

Fermo restando che la scelta degli 8 GB sulla 3070 non ha mai fatto impazzire neppure me, se tu la compri per giocare in 4K hai commesso un errore. A 1440P gli 8 GB non sono e non saranno un limite per anni.

Nessuno giustifica niente, ma la 3070 è una scheda da 800 euro (non dimentichiamoci che in realtà dovrebbe costare 600 euro) che va più di una scheda di 4 anni fa da 1400 euro.

Che poi tu non la compreresti è un altro discorso. I prezzi sono in salita da anni, e questo non fa piacere a nessuno.

Ultima modifica:

techsaskia

Utente Èlite

- Messaggi

- 3,279

- Reazioni

- 1,158

- Punteggio

- 133

Si certo, finché nvidia continua a produrre schede da 400 e passa watt che necessitano di alimentazioni e raffreddamenti da centrale nucleare è abbastanza ovvio ?

E con le 4000 ci sarà da ridere (o da piangere per chi le comprerà).

Tornando in tema intel, dimentichi l'imminente uscita delle schede intel.

Intel probabilmente sarà anche disposta a comprarsi fette di mercato inizialmente, che vorrebbe dire vendere le schede anche in leggera perdita.

Possono permetterselo e se serve lo faranno vedrai.

L unica cosa dove intel non potrà incidere al momento sarà la fascia alta (e infatti tremo a pensare al prezzo della prossima top amd multidie) ma sulla fascia media e bassa dovrebbe portare un bel po' di sana concorrenza.

Speriamo bene, ci spero veramente in un po' di concorrenza.

Lorenzo Lanas

Utente Attivo

- Messaggi

- 1,486

- Reazioni

- 887

- Punteggio

- 97

Imminente un cavolo?Tornando in tema intel, dimentichi l'imminente uscita delle schede intel.

Si parla di Estate 2022 e a quel punto sarà ormai troppo tardi, i buoi saranno scappati dalla stalla, già adesso si iniziano a trovare 3060 TI a 600€ e chi ha sofferto un lungo periodo di astinenza, sarà disposto a spendere "solo" 150€ per una GPU nuova. Spesa che si abbasserà ulteriormente all'uscita della serie 4000.

Insomma ... NVIDIA non è proprio scema scema scema, presto le produzioni torneranno auto-magicamente normali come prima (e pure più produttive) ?

fonte data uscita Alchemist:

Intel, Arc Alchemist desktop in estate: è ufficiale

Intel ha mostrato un teaser sulle GPU Arc Alchemist per sistemi desktop, dove mostra il design delle schede e il periodo d'uscita.

- Messaggi

- 33,071

- Reazioni

- 16,360

- Punteggio

- 254

insomma...A 1440P gli 8 GB non sono e non saranno un limite per anni.

fai un voletto con MS FS 2020 su New York in notturna...

- Messaggi

- 26,927

- Reazioni

- 14,675

- Punteggio

- 244

fatto. Non occupa tutto il frame buffer.insomma...

fai un voletto con MS FS 2020 su New York in notturna...

8 GB sono un limite nel 4K, su FS2020, e su pochissimi altri giochi oggi come Far Cry 6 con texture HD.

Però per quanto interessante sia la discussione, io direi di spostarla in Schede Video piuttosto che qui dentro.

Inquisitore

Utente Attivo

- Messaggi

- 311

- Reazioni

- 155

- Punteggio

- 59

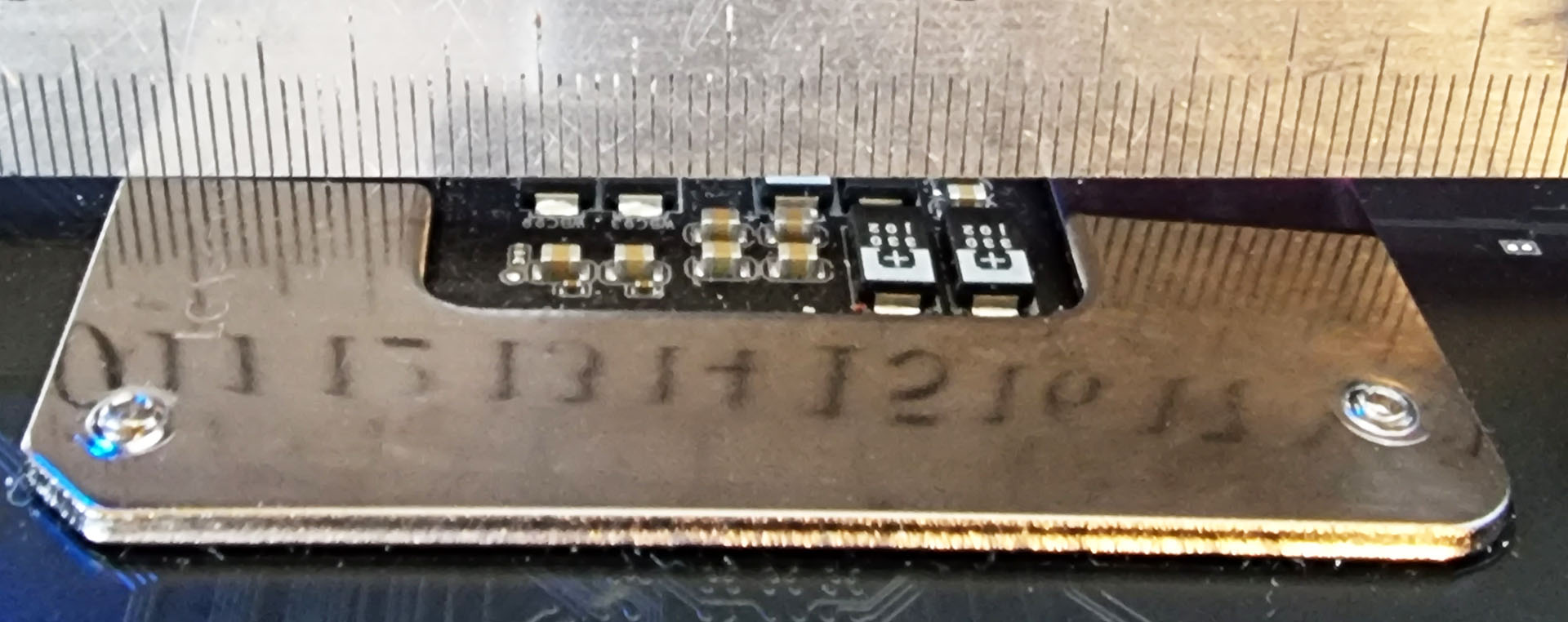

Ho appena visto un paio di articoli che dicono che la tendenza degli Alder Lake a piagarsi riduce l’efficienza di dissipazione di anche 5°C. Quanto è vera questa cosa?

Destroy139

Utente Attivo

- Messaggi

- 1,310

- Reazioni

- 255

- Punteggio

- 72

Verissima... Tantissimi utenti hanno avuto difficoltàHo appena visto un paio di articoli che dicono che la tendenza degli Alder Lake a piagarsi riduce l’efficienza di dissipazione di anche 5°C. Quanto è vera questa cosa?

Inquisitore

Utente Attivo

- Messaggi

- 311

- Reazioni

- 155

- Punteggio

- 59

Di bene in meglio...Verissima... Tantissimi utenti hanno avuto difficoltà

Pubblicità

Pubblicità