Anche io ho le fatture le mie ultime gpu sono state shappuire r9 280x presa a 275€ su eprice.

La shappire rx580 presa a 300€ sempre su eprice.

La RTX 2070s della kfa2 presa a 475€ su amazon.

La 3070Ti della Zotac presa a 800€ su amazon.

E ora la rx6600 per l'esperimento presa a 190€ su amazon.

Parliamo delle prime due che andavano in FHD (e alla grande la 280x la cambiai per le directx) Le altre due le presi per il QHD che uso anche ora con la rx6600...

Il prezzo tra 2070S e 3070Ti si è duplicato altrochè inflazione

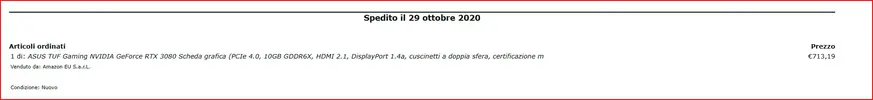

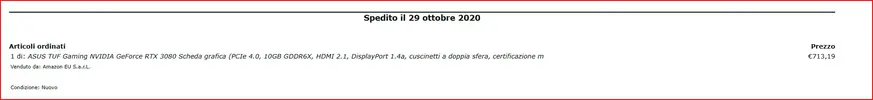

non puoi fare quel paragone tra la 2000 e la 3000 c'è stata la pandemia iuo la 3080 l'ho pagzata meno della tua 3070 ti

per buona parte delle RTX 3000 i prezzi sono srtati molto più alti di sempre per colpa dello shortage- bolla mining pandemia, che porto le semplici 3060 a costare quasi 700 euro

e la 3080 come la mia a prezzi che andavano oltre i 4000

Quindi dire che tra le 2000 e le 3000 i prezzi sono "aumentati" non ha senso in virtu del periodo storico eccezionale che si viveva /la pandemia appunto)

Se andiamo avvedere una scheda per il FHD OGGI costa 300 -400 euro (4060-4060 ti)

Schede per il QHD 650

In passato il 2160p lo vedevi con il binocolo finchè non sono uscite schede come 4000 non era una risoluzione gestibile

E' assolutamente senza senso fare un confronto sulla nomenclatura perchè le potenze grafiche in gioco sono cambiate

Una volta la 1080 ti che costava la bellezza di 650-700 euro era la top gamma potevi spingerai al massimo in QHD perchè in 2120p arrancava proprio come chip

Guarda caso oggi una scheda che gestisce bene il QHD (e lo gestisce decisamente meglio costa sempre 650 euro)

E' la risoluzione che gestisce la scheda che determina il prezzo e non la nomenclatura senza considerare poi che prima della serie 1000 era poco gestibile anche l'alta freq.

Il prezzo delle schede è andato sempre secondo questo livello/schema

FHD alta freq (300-450 euro)

QHD (600-750)

Qui entriamo in un territorio che è stato possibile gestire solo di recente cioè il 2160p e schede che riuewscopno a gestire il 2160p sono a partire dalla 4070 ti SUPER (900)

O la 4080 (1000-1200)

Le xx90 fanno storia a se

E come questo non sto giustificando nulla (ripeto) solo che dire che prima le schede "non costavano" è proprio una percezione sballata, perché le schede grafiche da che io ho memeoria sono sempre costate "care"

Guardando poi la cosa da consumatore oggi una scheda grafica la livello proprio tecnologico dura più a lungo del passato secondo me fermo restando che il tempo che ti dura una VGA lo decide l'utente, quindi è soggettivo, oggi la forbice con cui si usa una VGA si è molto ampliato

Comunque critichiamo quanto vogliamo Nvidia e il DLss ma intanto è una delle poche aziende che ha migliorato negli ultimi anni i suoi prodotti. AMD di buono aveva fatto solo i Ryzen con cache 3D che sono diventati inacquistabili, il colpo lo fece tra il 2019 e il 2020 prima con zen 2 e poi con zen3.

Dicevano che le RX 7000 sarebbe durare di più grazie alla RAM, intanto le RTX 4000 dopo due anni ha avuto un aggiornamento pesante. Me ne frega assai se fra 10 anni saranno obsolete

L'altra possiamo dire sia Apple con i suoi M4 e oramai la sua politica anti consumer viene quasi copiata dalle altre aziende, solo sugli SSD è peggio delle altre ormai.

Intel non pervenuta ormai, gli unici decenti lunar lake sono solo per I laptop e costano più di 1300€ andando come un M1 del 2020

nvidia ha migliorato enormemente l'intero settore, specialmente al livello di tecnologie messe in campo, ma questo non da ora da sempre, basti vedere tutte le tech demo che ha messo in capo nel corso della storia delle schede grafiche

Io volevo provare a puntare alla 5070 ti o al limite minimo alla 5070 ma i prezzi che si leggono/sentono in giro sembrano proibitivi (per me) pure per quelle...

Dovrei ripiegare forse su una 4070s usata

secondo me ti stai un pò fasciando la tersta prima di rompertela i prezzi delle XX70 saranno simili a quelli attuali