No no

--- i due messaggi sono stati uniti ---

In caso per una 5000 se c'è molta differenza, altrimenti no...occhio che ti si allunga il naso... :asd:

Segui il video qui sotto per vedere come installare il nostro sito come web app sulla tua schermata principale.

Nota: Questa funzionalità potrebbe non essere disponibile in alcuni browser.

Pubblicità

No no

In caso per una 5000 se c'è molta differenza, altrimenti no...occhio che ti si allunga il naso... :asd:

No ti dico, la TI nn mi interessa. In caso una 5000Esiste la scimmia 001, quella che abbiamo quasi tutti, quella gestibile, che spesso con cazzotti e buon senso la si riesce a gestire e poi ce la scimmia 002, quella di @Beex , inutile fargli anche brutto, armata fino ai denti e bulla. Stai certo che se esce la rtx 4090ti, dovrai fare i conti con la 002 e sono cazz. amari.

Visualizza allegato 458350

No ti dico, la TI nn mi interessa. In caso una 5000

quella è piccola la miia è gigante e mi svelgia la notteEsiste la scimmia 001, quella che abbiamo quasi tutti, quella gestibile, che spesso con cazzotti e buon senso la si riesce a gestire e poi ce la scimmia 002, quella di @Beex , inutile fargli anche brutto, armata fino ai denti e bulla. Stai certo che se esce la rtx 4090ti, dovrai fare i conti con la 002 e sono cazz. amari.

Visualizza allegato 458350

NOla Ti alla fine non sarà chissà cosa, quei 2.000 CUDA in più e al 99.99% moduli nativi a 24Gbps, non varrà assolutamente il biglietto per chi ha già una 4090...

puoi tirare tranquillo fino alla prossima top serie 5000 direi

La 3070 è stata castrata sin dal lancio, ed ancora peggio è successo per la 3070 Ti, che aveva un prezzo assurdo.What if NVIDIA made RTX 3070 with 16GB?

Modded GeForce RTX 3070 with 16GB memory gets major 1% low FPS boost - VideoCardz.com

What if NVIDIA made RTX 3070 with 16GB? Paulo Gomes and his friends came up with a new idea to upgrade NVIDIA’s last-gen RTX 3070 GPU memory. RTX 3070 with 16GB VRAM, Source: Paulo Gomes Memory mods on graphics cards are nothing new these days. Modders and technicians have been doing this for...videocardz.com

Se è vera fa brutto

NVIDIA NON AUMENTA LA PRODUZIONE DI RTX 40: LE VENDITE DELUDONO?

NVIDIA non aumenta la produzione di RTX 40: le vendite deludono?

NVIDIA avrebbe deciso di non aumentare la produzione delle schede video GeForce RTX 40, nonostante l'intera generazione sia stata lanciata.tech.everyeye.it

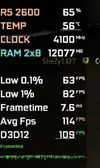

Il R5 2600 era una PESSIMA CPU da gaming, da sempre… non è un esempio calzante. Li non si tratta di bottleneck, ma di un architettura che sin dal principio era limitata nel gaming (tra l’altro un 6 core).A me non piace mostrare video perchè fortunatamente molto spesso guardo filmati ... di altra natura

Ho trovato 2 video che fanno un buon confronto, almeno spero, metto alla timeline di COD @ 1080p:

1° video 3070 con 2600 (tempo 2:30):

2° video 3070 con 5600x (tempo 12:04):

I settaggi sono quasi identici, il carico della CPU su entrambe è identico, il numero di core sono identici, ma guardate gli FPS e il relativo carico sulla GPU. Ripeto ancora, magari mi sono sbagliato in qualcosa però a me i settaggi paiono identici e una differenza di 40-45 fps per un settaggio secondario che mi sfugge mi sembra improbabile.

quella è piccola la miia è gigante e mi svelgia la notte

A proposito sto provando Alix in VR tutto al massimo a 120 fps la scheda manco si scalda

io uso il quest 2 ormia da un annetto e mezzo mi trovo bene `, non è il top dei visori ma è buonetto, molto versatileecco Alyx lo vorrei veramente giocare in VR, ma ammetto che mi sono molto allontanato da quel mondo da qualche anno a questa parte, ci sono novità? nuovi visori ecc? tu quale stai usando?

NO

Quando wsce la ti me la prendo 15GB di memoria video non bastano più

E' giusto la 4080 è da poveracci è una scheda che tra uin pò ci gira minecraft e poco altroimmaginavo, ma siccome sei un testone dovevi provare buttando 1200€ per rendertene conto...

24GB ad oggi sono proprio il minimo sindacale dai, le schede con meno vram sarebbero da bollino rosso, indipendentemente dalla risoluzione che poi uno userà...

E quindi quella architettura manda in bottleneck la cpu !!!non si tratta di bottleneck, ma di un architettura che sin dal principio era limitata nel gaming

io uso il quest 2 ormia da un annetto e mezzo mi trovo bene `, non è il top dei visori ma è buonetto, molto versatile

Alyx da solo vale l'acquisto del visore, cioè `è assurdo che quando metti il visore prende tutto profondità e sei li

pure Lone echo 1 e due sono fantastici

E' giusto la 4080 è da poveracci è una scheda che tra uin pò ci gira minecraft e poco altro

Che il numero di FPS aumenti non è mai stato in dubbio.Per me la situazione è questa.: c'è il mainthread del gioco che non è suddivisibile su più thread, quindi è limitato dalle prestazioni single thread che il sistema è in grado di garantire: a questo partecipano, non solo la CPU con la sua architettura e frequenza, ma anche la velocità delle memorie.

L'anomalia è che tu, giustamente, in un caso simile ti aspetteresti un core al 100%, ma non è detto che accada. Ricordiamoci che i software di misura monitorano i dati in intervalli di tempo piuttosto grandi,solitamente 1-2 secondi (poi comunque si può impostare). Una CPU moderna in 1 secondo fa qualcosa come 5 miliardi di cicli.

Lo scheduler del sistema operativo (Windows, in questo caso ma vale lo stesso con altri S.O) può decidere di tanto in tanto di spostare i processi da un core all'altro e lo fa a intervalli di tempo ben minori di 1 secondo. Il risultato è che, durante l'intervallo di monitoraggio del software, il core è stato impegnato al 100% per un certo intervallo di tempo in cui si è occupato del mainthread, poi il mainthread è stato spostato e il core è "andato in vacanza": del resto un 5900x ha 12 core e 24thread, ben più di quanto serva in qualsiasi videogame attuale.

Lo si vede bene anche facendo girare dei benchmark single core:

Visualizza allegato 458337

Questo è un Cinebench R23 ST fatto girare su un Ryzen 5800U (sono sul portatile): come vedete ci sono 4 thread impegnati e nessuno è al 100%. Eppure, per definizione, questo è un carico monothread... Magie dello scheduling. Ciò non vuol certo dire che se avessi una CPU più veloce in carichi single thread non completerei il task più velocemente.

Se fosse come dici tu cambiando CPU dovrebbe fare gli stessi identici FPS. Potrebbe anche essere vero, in qualche gioco, ma nella maggior parte dei casi la RTX4090 in QHD è frenata dalle prestazioni della piattaforma (RAM+CPU), non si scappa da questa cosa: ci sono un sacco di test online che lo dimostrano. Anzi, a volte lo è anche in 4k.

Quindi, posto che un Ryzen 5900x nei giochi moderni garantisce quasi sempre buone prestazioni (mettiamoci il quasi giusto per escludere casi strani tipo certe zone di Flight Simulator, dove in effetti ho sperimentato in prima persona difficoltà), una CPU migliore con la RTX4090 fa meglio. Mi sembra abbastanza ovvio e non capisco dove stia il problema in questo...

Comunque, @Kal El, ogni settimana ci delizi con uno scatto diverso di er giacchetta? Sei consapevole che tra i motivi che possono portare al ban c'è anche un'immagine del profilo "inappropriata" e sono abbastanza voglioso di applicare la sanzione?

il quest sui può usare senza fili, ma devi avere un router con le pallepiù che altro una caratteristica per me fondamentale è che sia senza filo, non sopporterei di avere un cavaccio tra i piedi...

il Quest2 infatti era quello che puntavo anche io qualche anno fa, poi mi sono successe alcune cose non bellissime e ho mollato tutto, ma vorrei recuperare terreno appena posso...

Alyx è uno dei titoli che vorrei proprio godermi in VR, senza contare i più classici giochi di guida (ACC, DiRT Rally, F1 ecc)...