Railgods

Utente Attivo

- Messaggi

- 294

- Reazioni

- 81

- Punteggio

- 52

Ma la vendita non è ancora aperta come fa a essere esaurito :)

Segui il video qui sotto per vedere come installare il nostro sito come web app sulla tua schermata principale.

Nota: Questa funzionalità potrebbe non essere disponibile in alcuni browser.

Pubblicità

Ma la vendita non è ancora aperta come fa a essere esaurito :)

Siamo in un pieno cambio generazionale dove le software house stanno preparando le nuove major dei motori grafici e tu non vedi rivoluzione.Io OGGI, vedo usare come benchmark giochi che vanno indietro fino al 2018 se non prima… nei prossimi due anni non vedo alcuna rivoluzione nel campo gaming in grado di cambiare il panorama in modo così netto.

è solo marketing e qualcuno ci sta cadendo con tutte le scarpe.

Parliamo del futuro e poi verifichiamo le prestazioni con Shadow of the Tomb raider e Ranbow Six…

Non mi stupisce e l’abbiamo visto accadere con Zen 4.Aggiungo il grafico di Der8auer, interessantissimo: lo sweet spot è a circa 285w.

Visualizza allegato 443496

Il mio messaggio forse può essere frainteso: con porcheria intendo il video di Digital Foundry, non il DLSS 3.0.

Sì, mi aspettavo renderizzasse i frame aggiuntivi partendo dalla risoluzione nativa: questo lascia intendere il video di 30 minuti. Mai accennato ad una riduzione della risoluzione.

Ma del resto non esiste alcun modo per accelerare se non renderizzando a risoluzione inferioreNvidia sara' stata volutamente vaga su dove potra' esser implementato il DLSS 3 (solo 4000 a anche GPU precedenti), ma quello della risoluzione era qualcos che era stato chiarito fin da subito, cito dalla pagina ufficiale del DLSS3 che abbiamo postato piu' volte:

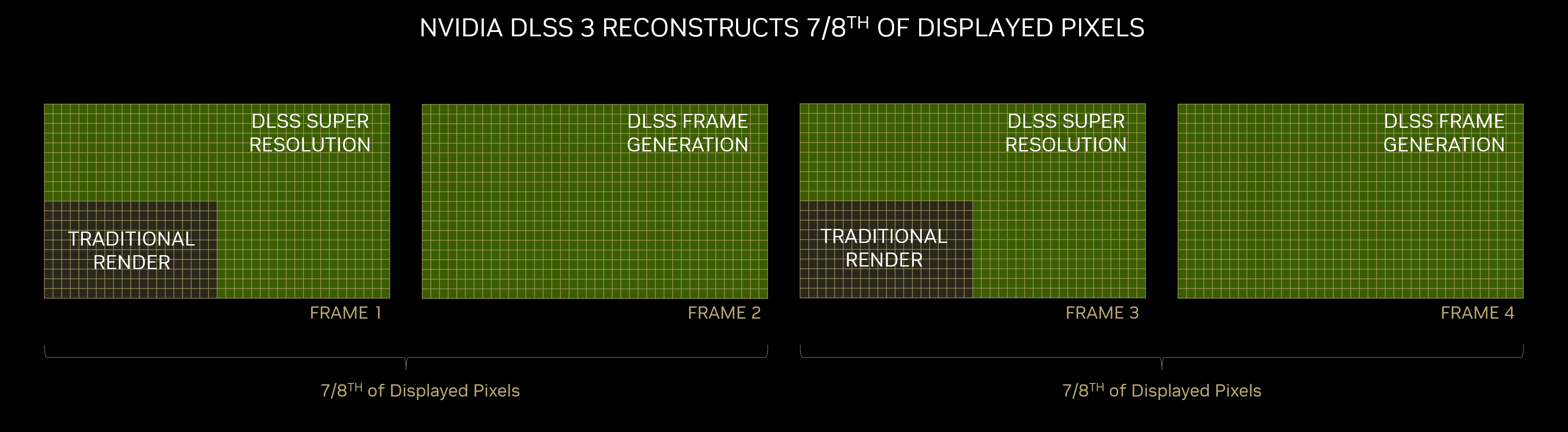

With DLSS 3 enabled, AI is reconstructing three-fourths of the first frame with DLSS Super Resolution, and reconstructing the entire second frame using DLSS Frame Generation. In total, DLSS 3 reconstructs seven-eighths of the total displayed pixels

Quindi il primo frame viene "renderizzato" solo per 1/4 della risoluzione nativa, e credo sia un parametro fisso.

I livelli del DLSS 3 immagino influiscano sul deep learning della AI, per operare sulla qualita' a discapito delle performances.

Mah, io lo spero ma non ho la stessa fiducia, specie sui consumi e soprattutto sui prezzi… La nuova AMD di Lisa Su non è molto diversa da Nvidia.Soprattutto quando tra poco, le rx 7000 di amd batteranno questa scheda, consumando meno, e penso anche ad un prezzo inferiore.

nvidia probabilmente lo sospetta e penso sia per questo che non l'hanno chiamata titan la loro scheda.

Tu hai veramente stancato con questo atteggiamento…questo thread si è trasformato in un thread di bambini che non si possono permettere il giocattolo e per questo motivo lo criticano.

ciao ragazzi. buona vita.

Per quanto condivida la tua sensazione, visto che ogni suo intervento del genere sfocia in flame su ogni thread, non lo apostrofare, andando contro il regolamento, ma segnala.Se ti apostrofo come “fenomeno” lo faccio solo per come ti poni qui in questo thread, da essere supremo(io sono io e voi non siete un c…o)e saccente all’ennesima potenza.

Inviato dal mio iPhone utilizzando Tapatalk Pro

Io ho spiegato i motivi per cui dico quello che dico. xDPer quanto condivida la tua sensazione, visto che ogni suo intervento del genere sfocia in flame su ogni thread, non lo apostrofare, andando contro il regolamento, ma segnala.

Multi die non significa nulla… o meglio non significa essere automaticamente più efficienti o più prestanti. È un approccio diverso che probabilmente rende più facile la scalabilità dei prodotti, ma sulle prestazioni vedremo.Amd ha il multi die, già questo potrebbe bastare.

Non avrebbero spinto così tanto la 4090 se non avessero paura della concorrenza (500w standard, 650+ con la funzione oc o qualcosa di simile... follia per un pc di casa).

Per il resto al momento mi reputo un fiero sostenitore dell'unico competitor della malvagia nvidia

Ma il discorso era lo stesso: la 3090/3090 Ti esattamente come la 4090 erano schede inutili, costruite solo per dire “io ce l’ho più lungo”.Su questo sono d'accordo. Anche se è una gpu che consuma tanto al confronto con la rtx 3090ti ne risulta vincente. Insomma stiamo parlando di una gpu che se la mangia a colazione e consuma uguale.

Ecco mettiamola cosi, giustifico i 450watt della rtx 4090 data la potenza che offre ma non riesco a giustificare i 450Watt della rtx 3090ti. Quindi dire che è una gpu che consuma tanto è corretto ma dire che è una gpu poco efficiente è sbagliato.

Si si, prendete pure le mie 3… credo che comprerò altroTranquillo te la lascio più che volentieri

Solo 90 FPS ?Comunque mentre voi parlate della 4090, io sto giocando a Valhalla con la 3090 bello fisso a 90 fps risoluzione 3480x1600 tutto al MAx.

Io dico che se vuoi giocare basta e avanza. Poi certo, bella scheda la 4090, nulla da dire. MA 2500 pippi..... insomma....

Però se proprio insistete me la compro...

Effettivamente è lo stesso ragionamento che stavo facendo io. Io ho una TV 4k a 120hz e un monitor a 160hz che uso sempre a 120hz per avere 10bit colore, ma acosa mi serve una scheda che fa 189 o 240 fps?Si è vero ma chiediamoci perché… ci serve giocare a 140 FPS in 4K ???

Stiamo continuando a giudicare la 4090 come una scheda da gaming, spinti anche da marketing .

A 1440P cerchiamo benchmark da 200/300 FPS dicendo che “la CPU fa da bottleneck”… e che senso ha cercare più FPS a quel punto ?

Quindi davvero ci siamo fatti convincere che 2000 euro per giocare vadano bene ?

Io non sono tanto perplesso sulle scelte hardware di Nvidia, con una scheda con picchi di oltre 600W, quando sulla reazione del web in cui non c’è nessuno che dica “ma a cosa serve quell’affare ?”.

Chiaramente escludo dal discorso chi fa rendering.

Si è vero ma chiediamoci perché… ci serve giocare a 140 FPS in 4K ???

Stiamo continuando a giudicare la 4090 come una scheda da gaming, spinti anche da marketing .

A 1440P cerchiamo benchmark da 200/300 FPS dicendo che “la CPU fa da bottleneck”… e che senso ha cercare più FPS a quel punto ?

Quindi davvero ci siamo fatti convincere che 2000 euro per giocare vadano bene ?

Io non sono tanto perplesso sulle scelte hardware di Nvidia, con una scheda con picchi di oltre 600W, quando sulla reazione del web in cui non c’è nessuno che dica “ma a cosa serve quell’affare ?”.

Chiaramente escludo dal discorso chi fa rendering.

Per le custom l'NDA sulle review scade oggima delle belle recensioni delle custom non si trovano ancora...

Che poi io veramente la 4090 la potrei prendere anche questa mattina se ci fosse, il punto è che ho valutato quante altre belle cose potrei comprare con 2500 E. Se faccio un calcolo probabilmente sforo anche i 2500Tu hai veramente stancato con questo atteggiamento…

… non ve lo potete permettere … ignoranti …

vivi su un piedistallo che ti sei creato nella tua mente e non fai altro che offendere il resto dell’utenza che consideri “inferiore” perché non ha la tua stessa disponibilità a buttare via soldi.

Per quanto condivida la tua sensazione, visto che ogni suo intervento del genere sfocia in flame su ogni thread, non lo apostrofare, andando contro il regolamento, ma segnala.

Che poi io veramente la 4090 la potrei prendere anche questa mattina se ci fosse, il punto è che ho valutato quante altre belle cose potrei comprare con 2500 E. Se faccio un calcolo probabilmente sforo anche i 2500. Il punto è che non ne ho voglia e soprattutto per un motivo: le aziende cominceranno a stare buone con i prezzi solo se le rimangono sul groppone i prodotti invenduti. PEr il resto , non mi va di criticare chi , avendo saltato 2 generazioni decide ( avendo conservato i soldi per4 anni) , di acquistare questa 4090 a 2500E. Non potrei, cambio HW in continuazione

MA infatti chi la prende.... in realtà aspetto AMD. Possibile anche che decida per 2 PC con GPU AMD e Nvidia. Sempre che mia moglie mi faccia vendere la 3080TI che io le ho rimediato ah ah ahCredimi non ne vale la pena il prezzo di queste schede è semplicemente assurdo

Se non devi giocare in 4K a dettagli dove noti anche i peli del c...o di ogni personaggio tienitela strettaSempre che mia moglie mi faccia vendere la 3080TI che io le ho rimediato ah ah ah

MA infatti chi la prende.... in realtà aspetto AMD. Possibile anche che decida per 2 PC con GPU AMD e Nvidia. Sempre che mia moglie mi faccia vendere la 3080TI che io le ho rimediato ah ah ah

MA si me la tengo, ma se AMD sfornasse aualcosa che mi da le stesse prestazioni della 3080TI ad un buon prezzo e a temperature inferiori e consumi inferiori, un pensierino lo potrei anche fare. La 4090 di certo, come ho detto, NoSe non devi giocare in 4K a dettagli dove noti anche i peli del c...o di ogni personaggio tienitela stretta

Se pensiamo che AMD è nel mondo console , ce la dice lunga....Anche se ci spero poco AMD ha davvero a disposizione un calcio di rigore, anche se nonc redo che lo sfrutterà o per lo meno non al 100%

Questo tipo di politica non fa che spianare pontio d'oro al mercato console