- Messaggi

- 5,082

- Reazioni

- 4,403

- Punteggio

- 159

Multy ha fatto una recensione a dir poco scandalosa. Hanno il dissipatore originale, probabilmente senza contact frame e l'i5 13500 gli è andato a 100 gradi durante la compilazione degli shader. Ma come cazzzzzo si fa a portare una cpu del genere a 100 gradi?!!! Sono degli ignoranti di prima categoria, ogni volta che parlano di hardware mi vengono i conati di vomito. Io ho un forno come cpu, e durante gli shader mi ha sfiorato max i 68 gradi.Basta con le giustificazioni dai, per favore, sono stanco, bisogna accettarle determinate cose, soprattutto quando dimostrate con dati!!!

la fonte è la review di Multy, ma chiunque, afferma ciò.

N.B.

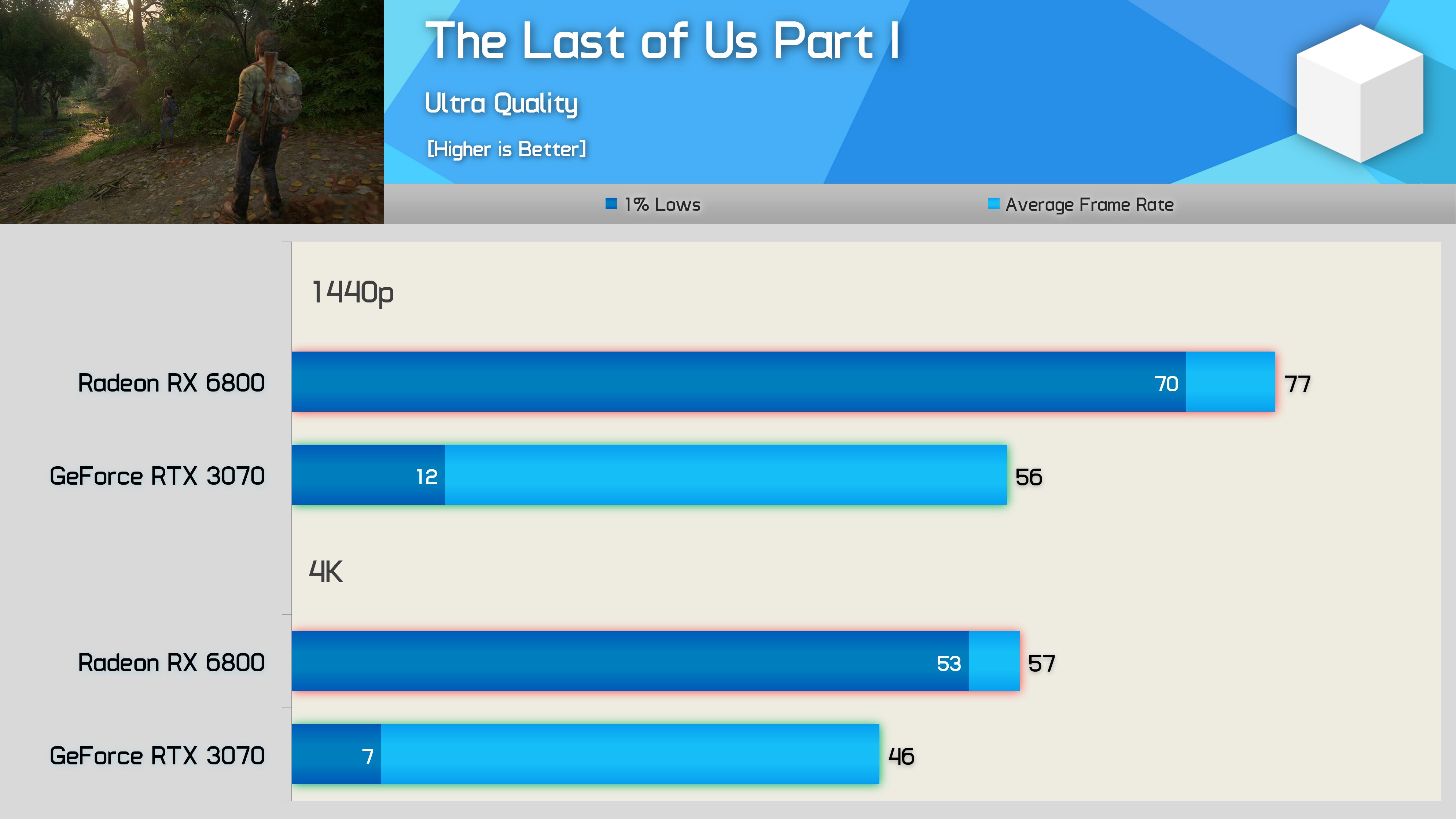

Io direi che oggi, possiamo/POTETE consigliare a chi vuole aggiornare per il 1440p, una GPU con almeno 12Gb di Vram, in ragione dei numerosi riscontri che stiamo avendo dagli ultimi giochi usciti, risulta quindi non consono e non attendibile, consigliare una gpu con meno di 12Gb di Vram per il 1440p nei giochi moderni.

Porca la miseria come fai a dare retta ad un sito del genere ??? Mi deludi.

Se un gioco arriva a saturare 12GB in 1440p, puoi credermi sulla parola se ti dico che quella software house non ha ottimizzato il gioco. Se dai un incarico del genere, come il porting di un capolavoro ad un team di sviluppo, il quale, la metà dei membri hanno frequentato la stessa scuola dei Teletubbies, ci credo che il gioco va a saturare tutta quella vram e crasha.