- Messaggi

- 26,929

- Reazioni

- 14,680

- Punteggio

- 244

oggi finalmente ho iniziato un gioco che riesce a mettere un minimo sotto carico la 4080 a 1440P.

Avengers con tutto a palla mi arriva al 100% di utilizzo (certo, con la CPU al 22% ), con un consumo poco sopra i 300W e frame rate elevato.

), con un consumo poco sopra i 300W e frame rate elevato.

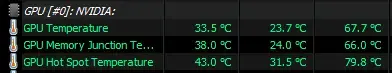

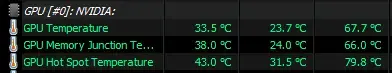

Le temperature, con 22° di Tamb, restano ottime

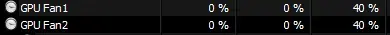

considerando che le fan non superano il 40%

Hai le idee confuse, come sempre...

Ma poi non perdi il vizio di giudicare l'hw con titoli appena usciti e buggati.

Avengers con tutto a palla mi arriva al 100% di utilizzo (certo, con la CPU al 22%

Le temperature, con 22° di Tamb, restano ottime

considerando che le fan non superano il 40%

8GB ? Ma se tu parlavi della 3080 che di GB ne ha 10 !Signori e signore com'era il discorso della Vram, che 8GB sono sufficienti per il 1440p???

Andate a dare un'occhiata a TLOU parte I per Pc, andate andate.

Ah ok, voi vi riferivate a giochi del 2019, si, in quel caso è sufficiente ;)

#KalHaSempreRagione

Hai le idee confuse, come sempre...

Ma poi non perdi il vizio di giudicare l'hw con titoli appena usciti e buggati.