4) tutti dicono che non va una 3080 in full hd ma non capisco perche... nel senso se voglio fare piu fps possibili la risoluzione migliore per fare fps è 1080p, gia se vado su un 2k vado a perdere fps e non pochi rispetto al 1080p sbaglio ? anche se sono un po in bottleneck comunque farei sempre piu fps di una 3070 o no?

?

Te lo spiego io.

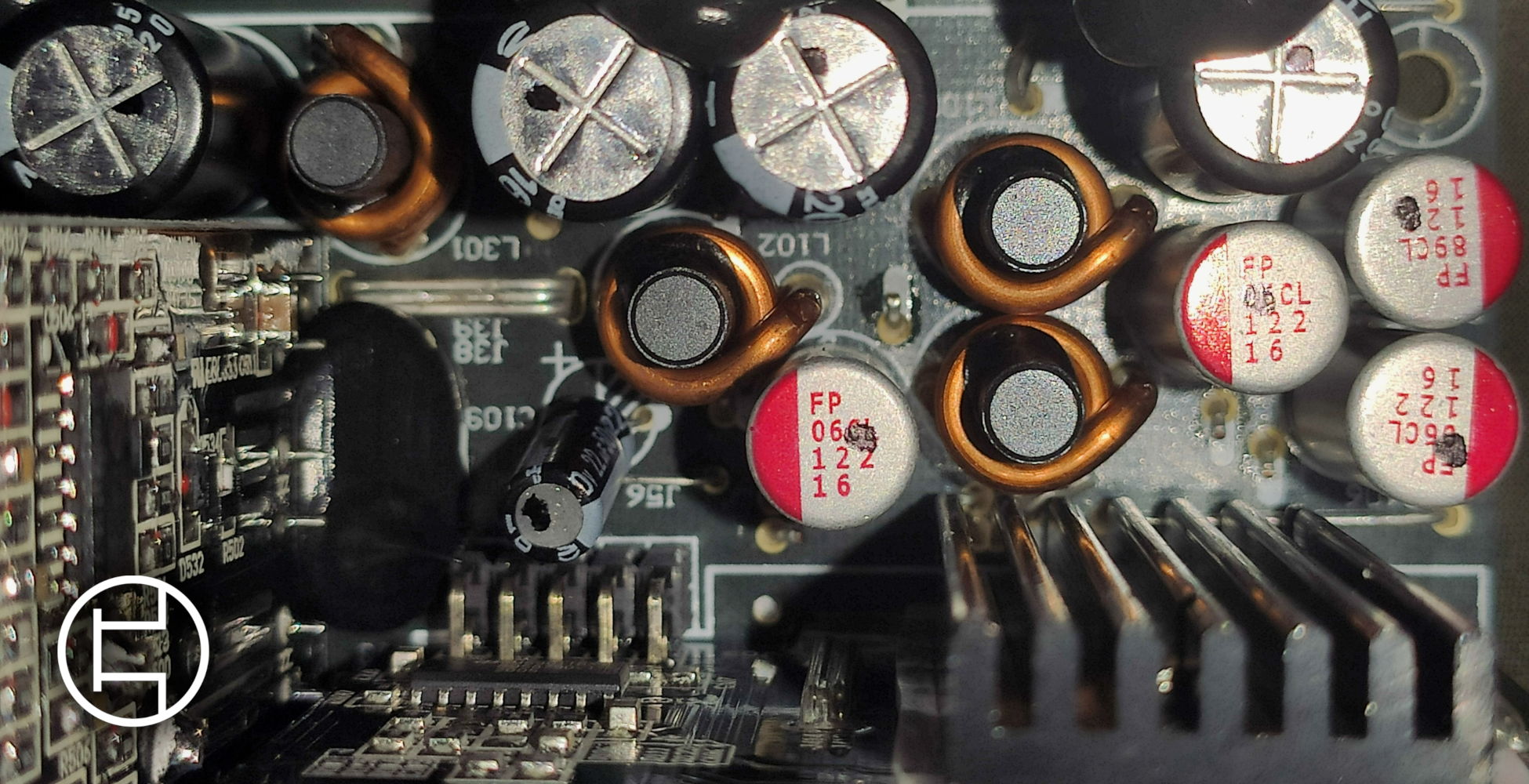

Ampere è un architettura che ha dei pro e contro come qualsiasi altra architettura. Tra i contro di questa architettura vi è un problema dovuto al grosso numero di cuda core che queste gpu montano.

Infatti il salto tra turing e ampere nella conta dei cuda core è stato mostruoso, più del doppio.

Questo però cosa comporta ? Comporta che l'architettura si "auto/strozza", mi spiego meglio.

Una rtx 3080 che ha 8704 cuda core non riuscirà mai a sfruttare tutti quei core con un carico cosi leggero come può essere un videogame in 1080p. La mole di dati che deve elaborare la gpu è talmente poca che spesso più della metà dei cuda letteralmente dormono. Per riuscire a sfruttare una rtx 3080 in 1080p al 100% servirebbe un gioco di ultima generazione sparato al massimo, un monitor da 360hz e una cpu mostruosa di fascia enthusiast con un altissimo ipc che riesce a stare dietro ad una rtx 3080 con quel alto refresh rate e forse in questo caso estremo si riesce a sfruttarla.

Questo problema di Ampere lo si può notare anche con una semplice rtx 3060 dove in 1080p prende le mazzate dalla rx 6600xt ma non appena si passa al 1440p, il gap tra le due si riduce al minimo, questo per lo stesso motivo speigato precedentemente, cioè che la grande mole di cuda core della serie rtx 3000 vengono sfruttati in pieno al aumentare della risoluzione ( cioè del carico di lavoro ). Non mi fraintendere questo non significa che chi ha una rtx 3060 dovrebbe giocare in 1440p e non in 1080p, significa solo che la rx 6600xt all'aumentare della risoluzione soffre maggiormente rispetto la rtx 3060 e quest'ultima riesce ad accorciare il gap prestazionale, ma è ovvio che la rtx 3060 sia una gpu per il 1080p.

Ora ho delle domande da farti:

1- Hai un cpu come un i9 12900k o un i7 12700k ?

2- Hai un monitor 1080p da 240/320hz ?

1920x1080p = 2 073 600 pixel in totale

2560x1440p = 3 686 400 pixel in totale

3840x2160p = 8.294.400 pixel in totale

Come puoi vedere il QHD ha quasi il doppio dei pixel da elaborare, mentre il 4k ha quattro (QUATTRO) volte i pixel da elaborare rispetto al 1080p.

Ora le ultime due domande finali:

1- Se questa gpu è stata progettata per il 4k, non ti sembra "stupido" investire tutti quei soldi per poi utilizzarla in 1920x1080p ?

2- Ma che caz.... te ne devi fare di tutti quei fps ?

cultists.network

cultists.network