- Messaggi

- 86,060

- Reazioni

- 38,943

- Punteggio

- 253

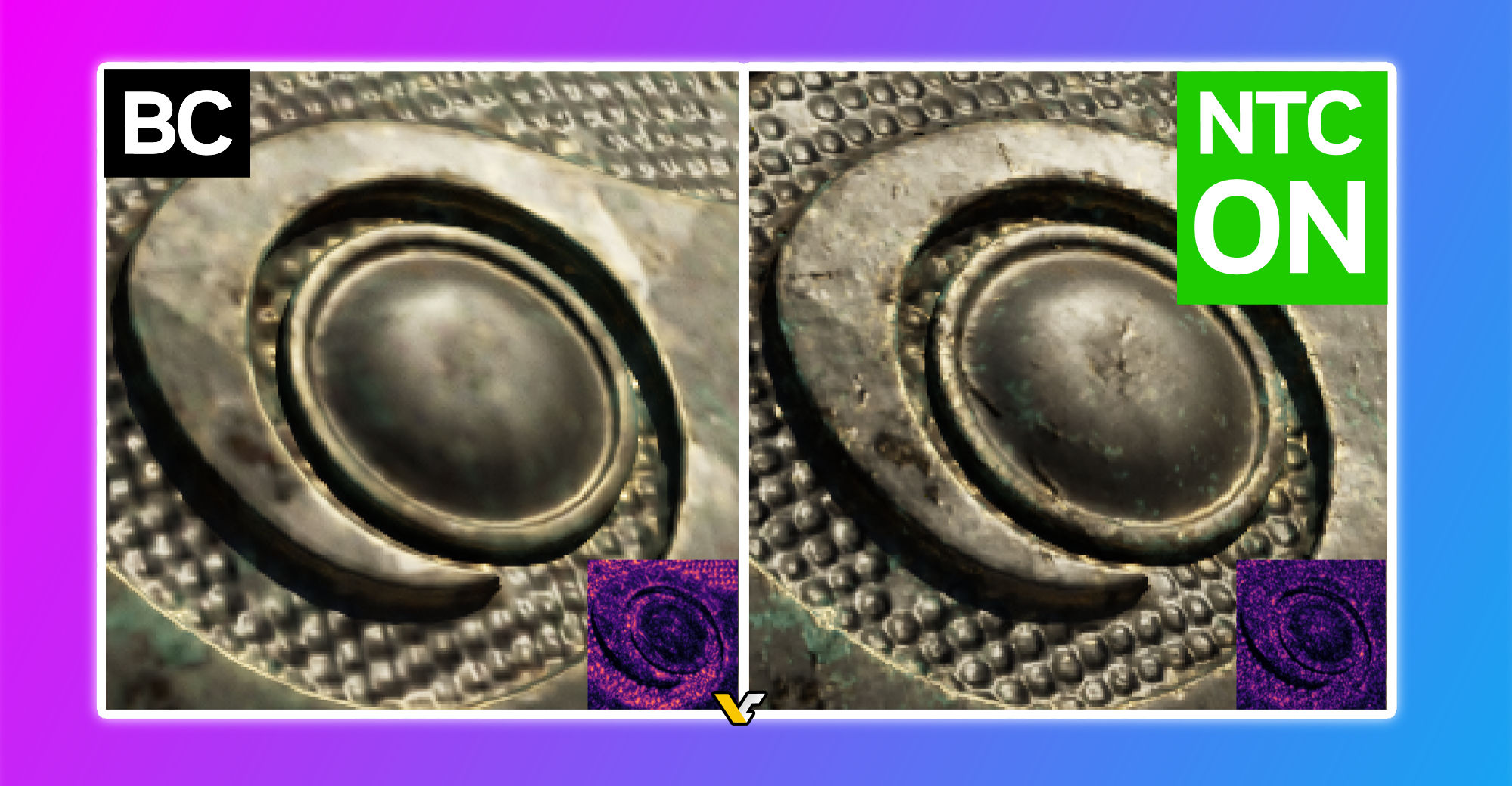

ma il punto e che non hjo visto saturare 12 gb di vrma nemmeno in VR sul quest 3Si preoccupano che 12GB di vram siano pochi per il 2560x1440p, manco fosse chi sa che risoluzione, parliamo di 3.7 milioni di pixel. E già tanto se si arriva a saturarne 8GB, ma li ci pensano gli sviluppatori cani, che in quello sono bravi, altrimenti in qualsiasi altro software, ottimizzato non dico bene, ma almeno decentemente, si sta tranquillamente sotto gli 8GB.

In ogni caso, esistono quei geroglifici nelle impostazioni, sezione grafica, chiamati: "Impostazioni Grafiche", che se utilizzate con cognizione di causa, possono fare miracoli sotto questo punto di vista.

E credimi ho provato a mettere il rendering al 300% con una risoluzione di 4128x2208

MA fa bene dire che uno ce l'ha più lungo