pribolo

Utente Èlite

- Messaggi

- 38,481

- Reazioni

- 13,888

- Punteggio

- 253

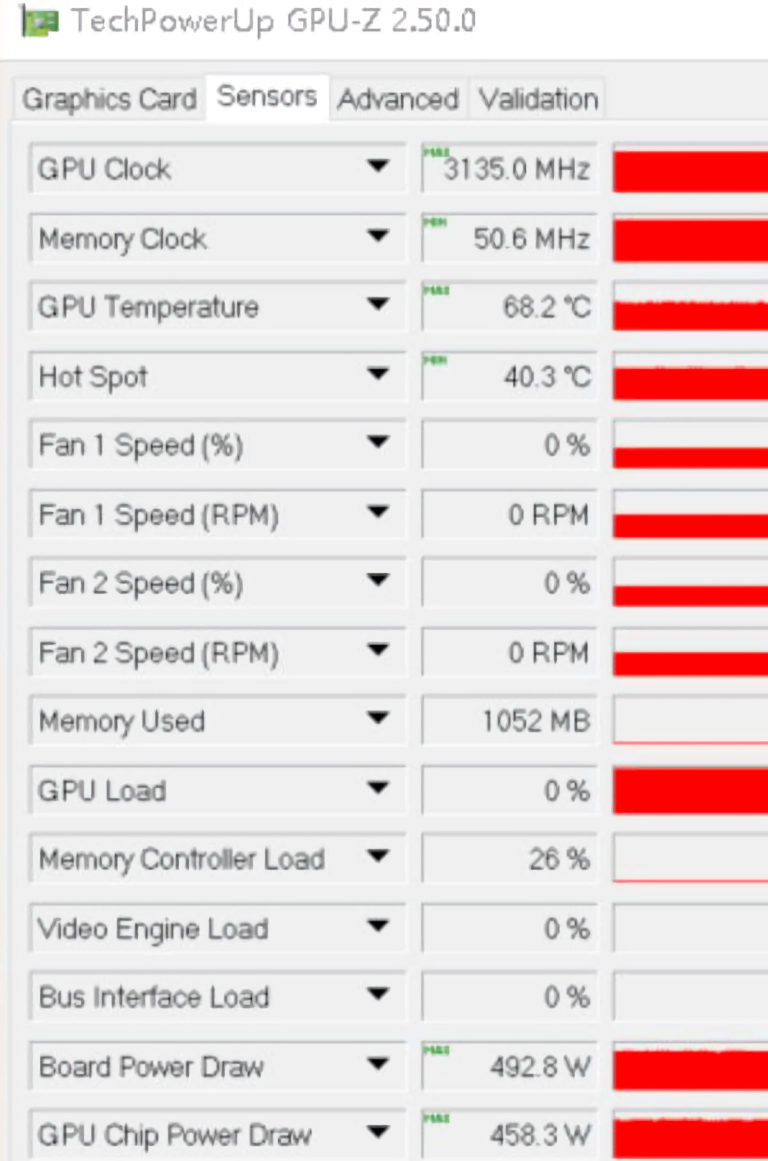

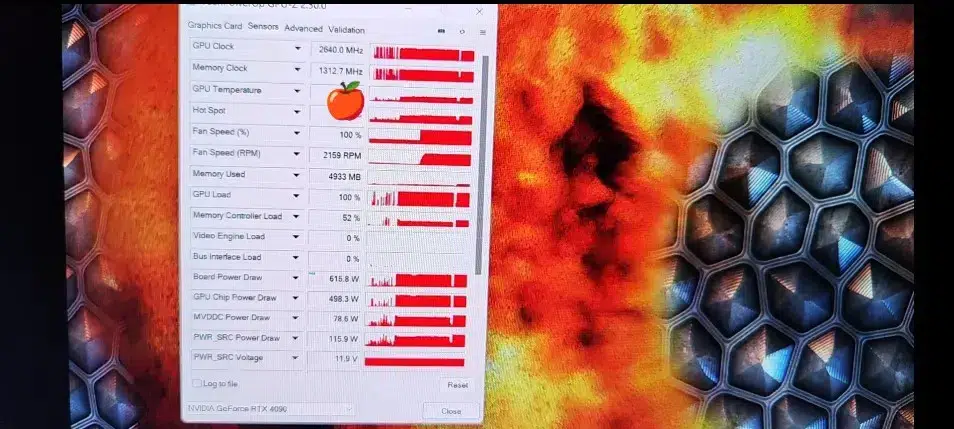

La 4090 è fuori discussione`, troppo grossa consuma troppo, la 3080 onestamente mi basta la mia la si può chiamare semplicemente "scimmia"

E allora lascia perdere. Stai con la RTX3080 fino alla prossima infornata, o quanto meno aspetta AMD.

Le 4080 convincono proprio poco: l'unica cosa che mi incuriosisce è il DLSS 3.0, ma tanto all'inizio ci sarà una fase di rodaggio (anche in termini di numero di giochi supportati).