Perché il concetto di entry level non dovrebbe esistere? Tutte le risoluzioni hanno delle fasce di prezzo di riferimento, chiaro poi che per il 4K non puoi puntare su una GPU di fascia medio-bassa. Dire che oggi per giocare in 4K serve minimo una 4070 Ti imho è sbagliato. In 4K puoi giocarci anche con una 3070 volendo, basta soltanto lavorare bene con le impostazioni grafiche.

se hai preso una 3070 per giocare in 4K, hai sbagliato dal principio. Oggi puoi farlo ? Certo, con dettagli medi puoi farlo.

Ma quello non è "entry level"... è un adattarsi per via di un acquisto errato.

Che la 3070 non fosse idonea al 4K lo si sapeva anche nel 2020 quando è uscita.

A mio avviso l'esperienza "entry level" nel senso di PC gaming significa giocare a 60fps stabili a dettagli grafici che restituiscono un impatto visivo massimo o indistinguibile da esso (tipo ombre su High invece che su Ultra che non hanno alcun impatto visivo ma ti fanno risparmiare 10fps).

Detto questo, oggigiorno non sceglierei una 3070/Ti per il 4K perché siamo nel mezzo di un periodo di transizione in cui i giochi, a quelle risoluzioni, cominciano a saturare gli 8GB di memoria. E se pensate che HL, RE4 e TLOU siano delle eccezioni, e che in futuro i giochi continueranno comunque a rientrare negli 8GB, vi faccio un grande in bocca al lupo.

Il fatto che OGGI, HL sia perfettamente giocabile a 1440P con 8 GB di VRAM lo ignoriamo bellamente vero ?

E guarda caso i possessori di schede Radeon, che hanno il frame buffer come unico punto di forza, tendono ad ignorarlo più di altri

RE4 gira a 1440P con una 3070, ed anche li le patch stanno risolvendo i problemi.

resta TLOU, ma è solo questione di tempo.

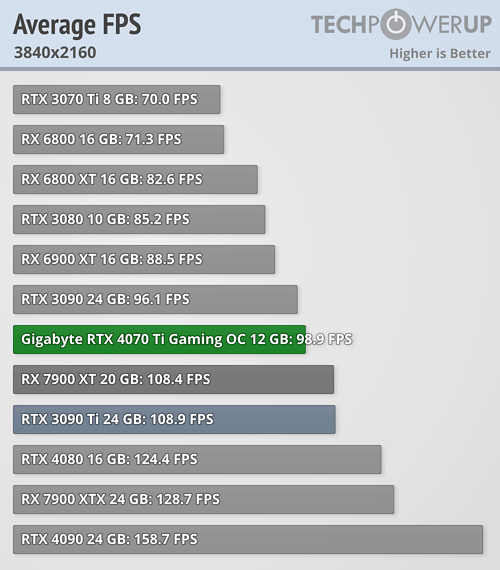

Per questo per me bisogna partire dalla 6800 XT/ RTX 3080. La 4070 Ti è sicuramente meglio, ma costa 300€ in più, e a mio avviso quel grosso investimento non ripagherà per tanto tempo, dato l'enorme e inaccettabile decadimento di performance in 4K rispetto alle altre risoluzione visibile già ora. Se le sopraccitate GPU fra (diciamo) 1 anno costringeranno ad abbassare la qualità visiva in maniera vistosa per garantire i 60fps, la 4070 Ti lo farà fra 2 anni. Con i giochi che usciranno tra 3/4 anni, anche la 4070 Ti sarà tagliata fuori. Quindi no, per me la 4070 Ti è una scheda per giocare in maniera ottimale con il RT in 4K e DLSS attivo, ma NON è un investimento a lungo termine per il 4K.

Se anche fosse come dici (e credo che il DLSS 3 faccia ancora più la differenza) per me un anno in più vale quei 300 euro eccome. Io oggi per varie ragioni considero più sensato spendere 900 euro per una 4070Ti che 600 euro per una 6800XT. Chiaramente tolgo la 3080 dall'equazione perché ai prezzi a cui si trova non ha alcun senso (prendo una 4070Ti direttamente).

Peraltro se una 3070, uscita nel 2020, va ancora bene con tutto nel 2023, non vedo perché tra 3 anni la 4070Ti non debba fare lo stesso. Anche la 1070Ti oggi è ancora usabile, fatte le dovute regolazioni, con soddisfazione.

Per me è importante distinguere tra chi una scheda la possiede già e chi la deve prendere. Se possiedi una 3080 o una 6800XT, sono d'accordissimo nel non cambiarla (e non certo per una 4070 Ti !). Se invece parliamo di un acquisto da fare ora, non sono schede da considerare.

Se Nvidia avesse deciso di non castrare questa scheda con quel bus probabilmente lo sarebbe stata, ma chi spende quei 3-400€ in più rispetto alla fascia sweet Spot delle 3070/Ti/6800/XT, è importante che sia consapevole del fatto che lo fa per avere l'esperienza gaming ultimate OGGI, non fra 3/4 anni.

parli di "quel bus" ripetendo un meme che gira sul web senza senso. Può tu non sappia esattamente cosa implica.

Ti rendi conto che il bus che continui a denigrare è di 192 bit ? La tua 6800XT ha un bus da 256 bit, quindi poco più largo, ma la VRAM disponibile per la 4070Ti è di 21 Gbps mentre nella tua 6800XT come nella 6900XT è solo 16 Gbps. Il bus è un numero che da solo non significa nulla. La banda disponibile con le due soluzioni è pressoché identica (504 Gb/s vs 512 Gb/s), quindi se era idonea la 6900XT adesso lo è la 4070Ti.

Io concordo con il tuo ragionamento con alcuni "ma", quello che mette fuori gioco le Nvidia al momento è sempre il prezzo, una 6800 xt te la porti a casa a meno di 600 euro al momento, il che non è male, calcolando anche i 16gb di vram, vedremo la 4070 liscia ma per me starà sui 700 euro con la TI sui 900, e non è poco....

ribadisco: quando vedete i prezzi delle radeon serie 6000 oggi così bassi chiedetevi il motivo. AMD è scesa sotto al 7% di market share, sulle GPU.

Quelle schede costano poco perché di fatto nessuno le vuole.

E tra i motivi ci sono i tanti, troppi problemi che hanno causato negli anni.

AMD aveva un calcio di rigore a porta vuota, con la serie 7000. Nvidia in ritardo, con prezzi fuori dal mondo ed offerta incompleta.

Come hanno risposto ? Con schede ancora deboli in RT, a prezzi comunque altini e con porcate pure peggio di Nvidia (la 7900XT è ancora peggio della storia 4080 12/16 GB che alla fine Nvidia ha ritirato prima del lancio). Il tutto con un offerta ancora incompleta: le 7900 lanciate in realtà sono delle "7800" (nessuna compete con la 4090), le 7700 e 7600 ancora non si vedono perché AMD vuole mungere i suoi stessi fanboy.

Ah si, però hanno 16 GB di VRAM...