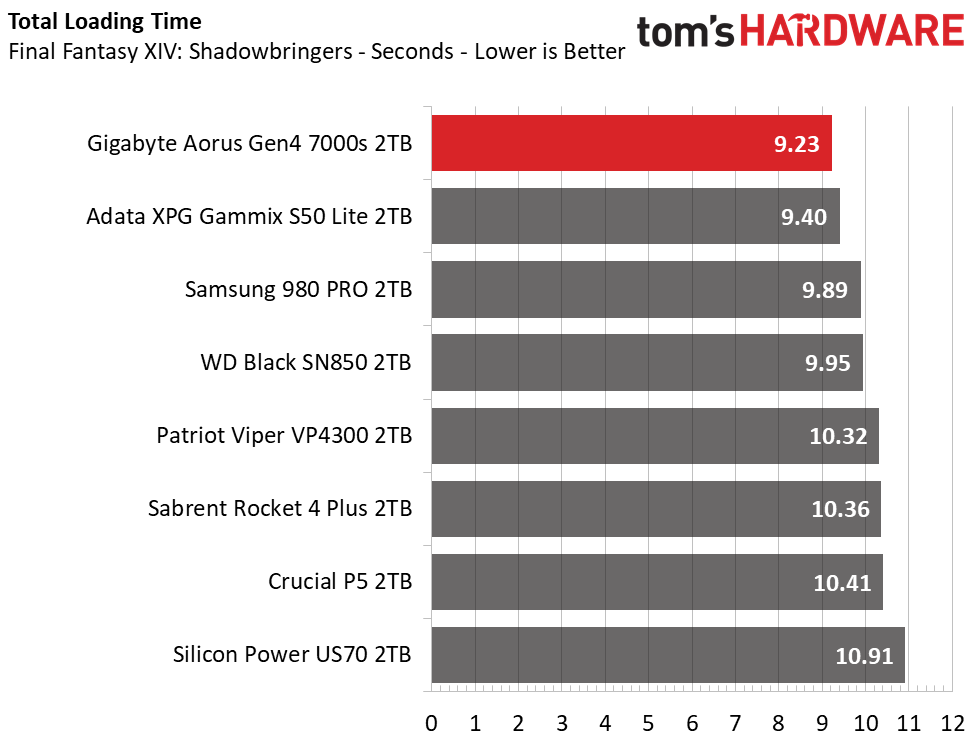

Il primo test è di lettura utilizzando un software che fà parte di 3DMark e che potete scaricare tramite Steam.

Testa l'uso dell'ssd nei giochi, ovviamente lettura... i giochi quello fanno con gli ssd.

Un test che serve solo a fare confronti di punteggio ma che ad esempio poteva comprendere DirectStorage di Microsoft (ad esempio). Occasioni mancate!

Come si può vedere dai grafici abbiamo tre fasce di prestazioni... guarda caso corrispondono alle generazioni di nvme pcie 5.0 /4.0 (o con celle QLC)/3.0

Mi pare ovvio... proprio ad ogni salto generazionale pcie aumenta il bandwidth ed è possibile utilizzare dei controller più performanti da cui si ottengono prestazioni migliori.

Inoltre sono omessi degli ssd della stessa categoria come poi il testo dice:

....ciò mette il Phison E18 e controller di classe simile, come SM2264 e IG5236, in un po' di difficoltà, ma vale la pena menzionare che questi sono dietro al WD Black SN850X, SK hynix Platinum P41/Solidigm P44 Pro e 990 Pro. L'NM790 è nella posizione migliore per spodestare i vecchi design E18 e IG5236 piuttosto che raggiungere la corona delle prestazioni.

quindi in effetti volendo fare le cose fatte bene, prima del NM790, ci sono degli nvme omessi di pari o superiore velocità di lettura.

Questo non vuol dire che il modello non sia valido, ma che il grafico è architettato per farlo risaltare in un panorama di nvme che hanno pari prestazioni.

Secondo discorso, sempre riferito a questo primo test, la lettura è la parte predominante (latenza) mentre la parte di scrittura risulta talmente esigua e poggiante sulla cache... che appiattisce come già detto i valori per tutti gli nvme dotati di pSLC.

Il secondo benchmark è sempre della piattaforma di 3DMark e sempre si può scaricare mediante l'account Steam.

Testa una condizione di uso office... molto banalmente fà più riferimento al tipo di hardware dell'ssd che non ha reali prestazioni dello storage, poichè anche un banale hdd farebbe bene in questo bench.

Il risultato è che ricalca quello sopra; gli ssd risultano divisi a seconda della classe di pcie e di celle.

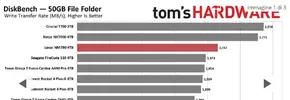

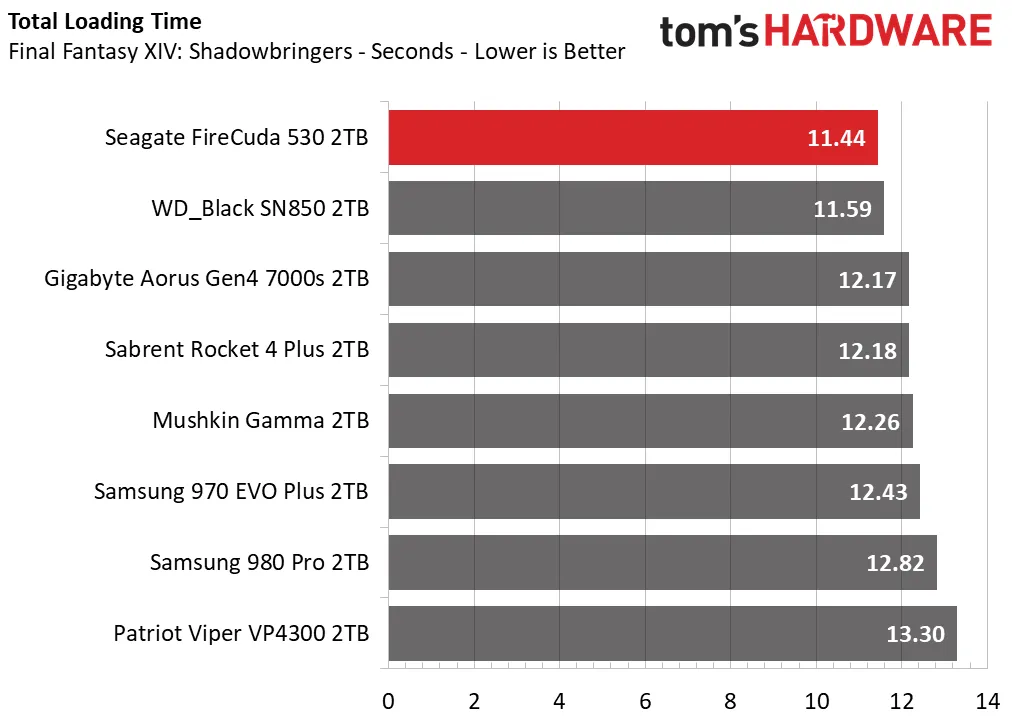

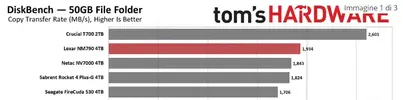

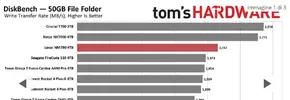

Il terzo bench della pagina di review di THW riguarda ora la scrittura.

Visto che nella scrittura dell'ssd entrano in gioco molti elementi, dovrebbe essere un test dove vedere risultatati diversi.

Infatti il controller deve essere buono nell'hardware, nel firmware (la programmazione), gestire o meno l'HMB, le nand devono essere più o meno veloci (sia di tipologia che di generazione).. tante cose che più o meno possono influire.

DiskBench è un programmino gratuito che non fà altro che misurare la velocità di trasferimento. Molto semplicemente.

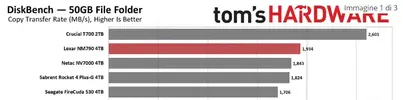

THW ha composto una cartella di file da 50 GB e uno zip da 6,5 GB e li da in pasto all'ssd per scriverli o leggerli.

Sinceramente ignoro il motivo per cui non ci sia anche le prestazioni di lettura della cartella da 50 GB o la scrittura dello zip da 6,5 GB... e non so neanche la differenza tra "copia" e "scrivi", visto che come scrive l'autore del software:

Tutto ciò che fa è:

1) copiare un file (cartella) da A a B, moltiplicare il tempo impiegato e cancellare di nuovo il file da B.

Concentrandosi sulla scrittura (la sola parte che interessa) la "forma" del risultato è quella vista in precedenza: ssd nvme di classe pcie superiore che sono anche più veloci a scrivere sequenzialmente... banale ovviamente.

Andando ad analizzare

Li prendo entrambe nel dubbio, e vedo che il T700 forte di un hardware migliore (Phison E26 pcie 5.0 associato alle ultime e veloce nand Micron), domina la scrittura. D'altra parte il controller ha a disposizione il doppio di capacità di scrittura

e nella realtà anche se non doppia i pcie 4.0 scrive parallelamente meglio su più die delle nand... quindi ci siamo che sia più veloce, ma sappiamo anche che la latenza grava anche su questo dispositivo, per cui meglio si, ma... non di tantissimo.

A parte il Netac (vediamo dopo) il nostro NM790 è li davanti a tutti: Seagate, Sabrent (che hanno comunque stesso controller anche se nand Micron di generazione diversa).

Hanno però una cosa in comune, ovvero sono dotati di di DRAM DDR4 on pcb.

Le prestazioni "anomale" del Netac NV7000, che se andiamo a vedere ha lo stesso hardware del Seagate Firecuda, dimostra una velocità di scrittura fantastica per un pcie 4.0; in realtà neanche il recensore di THW da una spiegazione a questa prestazione

https://www.tomshardware.com/reviews/netac-nv7000-ssd-review/2 se lo stesso firmware è presente sul Seagate non è una questione di programmazione, forse una anomalia, forse...

Tralasciamo questa storia e concentriamoci sul fatto che un DRAMless (HMB) possa competere in scrittura sequenziale con quelli che il chip ce l'hanno e dunque hanno un costo produttivo maggiore.

LA spiegazione è, penso, la più banale... 50 GB alla velocità di scrittura nominale di questi nvme pcie 4.0 (6.500 MB/s), sono in effetti 6,5 GB/s cioè 7,6 secondi

ovviamente stiamo testando la velocità della cache SLC dell'nvme, per cui il commento che THW fà

Il bus da 2400 MT/s e l'ampia quantità di die flash aiutano davvero l'NM790 a spingere la larghezza di banda per la copia dei file.

è giustissimo.. a parità di cache SLC con gli altri, vince il controller più veloce/nuovo accoppiato alle nand più veloci sul mercato.

Rispecchia la realta del nostro ssd nvme pieno di giochi o con il sistema operativo?

Ovviamente "ni" perchè l'ssd in questione è vuoto ed è un ssd secondario. Nella realtà il nostro ssd ha una cache pSLC cappata e magari richieste in background che determinano cali prestazionali in scrittura.

Se diamo poi da scrivere contemporaneamente più cose pesanti al nostro ssd DRAMless, ci accorgeremmo che i cali sono evidenti poichè l'aggiornamento delle mappatura sequenzialmente è più lenta.

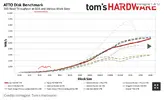

Passiamo ai bench di ATTO e CrystalDiskMark. Sono software gratuiti e sono da prendere per ciò che sono: danno grossomodo l'idea delle potenzialità del ssd, ma non sono degli stress-test.

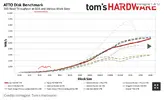

Atto scrive o legge per blocchi (un po come si può impostare anche DiskBench). Più il blocco è piccolo maggiore è il peso della latenza nel tempo che ci impiega (1), se il blocco (da leggere o scrivere) è abbastanza grande, la latenza è compensata e ci si trova in una condizione di stabilità nelle prestazioni (2)

Ora, cosa interessa vedere in ATTO?

La lettura dei blocchi tra 512KB e 4K (la dimensione del Blocco) con una coda di comandi simile a quella che farebbe un Windows, cioè QD 2 - 4

Mettiamo che sia questo, anche se l'hanno impostato con nessuna coda dei comandi

Diciamo che messo così il grafico è poco significativo...possono anche evitare.

Per esempio, nel grafico sopra THW rileva un anomalia nella lettura per 0,5 MB in poi (si vede il grafico che non è progressivo).

La cosa è rilevante ma non importante, poichè non è il solito modo con cui opera un sistema operativo se non con particolari richieste come ssd usati in DB ad esempio.

Crystadiskmark lo conosciamo, sappiamo cosa può misurare. L'unica cosa da tenere presente è che la misurazione delle prestazioni è spot e poi moltiplicata per un tempo superiore, quindi non mette alla prova realmente l'ssd con carichi significativi.

Andando in ordine di sequenza dei grafici:

a) la lettura random del blocco 4KB è nella media - questo test è il più vicino alla realtà ed il più importante, essendo la capacità del controller ad accedere alle informazioni al netto di potenza hardware, firmware (ECC), latenza, velocità delle celle nell'accesso ai dati.

Chi fà il valore più alto di questo, fa il jackpot, perchè vuol dire ritrovarsi con un ssd reattivo.

b) se alla lettura di un file da 4KB del test di prima, aggiungo 256 richieste contemporanee, ottengo naturalmente un ssd che più ha memorizzato su die diversi e più ha capacità di attingere dai die parallelamente, più va forte... ovviamente il pcie 5.0. E poi i pcie 4.0 e poi i pcie 3.0 e/o QLC.

c) la misura della latenza della lettura, ricalca il test a)

d) scrittura... iniziando con la scrittura del singolo file da 4KB senza coda di comandi. La prestazione deludente non è legata al fatto che l'ssd sia DRAMless, quanto ad una caratteristica sua (anche altri ssd con NAND YMTC Xtacking 4.0 hanno questo gap). Non è una cosa limitante, le scritture sono in prevalenza sequenziali e con DiskBench si è visto che và normalmente.

e) Scrittura file 4KB contemporanea di 256 file... la coda I/0 ha difficoltà (vedi motivo sopra).

f) la latenza di scrittura (importante per I/0) è molto alta, ma non è il caso di preoccuparsi. Certo però un purista degli ssd che vede questa vicinanza

un ssd così, lo evita.

g) Passando alla lettura di un file più grande (1MB, cioè quello che crystaldiskmark chiama test sequenziale) senza coda è buonissimo

h) aggiungendo 1MB con coda rimane buono

i) la scrittura sequenziale (1MB) senza coda, soffre ancora di una alta latenza delle celle (vedi d,e,f)

l) idem la scrittura di 1MB con un poco di coda di comandi

Il commento del recensore:

La latenza di lettura casuale è nella media, mentre la latenza di scrittura casuale è tra le peggiori. Ciò è dovuto in parte al controller, che non sarà potente quanto i design a 8 canali con DRAM dedicata. C'è anche il fatto che la flash è un design a sei piani, il che migliora la larghezza di banda per die ma non necessariamente la latenza. Naturalmente, i compromessi hardware valgono la pena, poiché questa combinazione è piuttosto efficiente dal punto di vista energetico.

Colpa del controller e delle nand insieme?

Comunque secondo me le basse scritture I/0 non sono un problema; l'ssd deve essere forte in lettura casuale e sequenziale e in scrittura sequenziale, per uso vario e gaming.

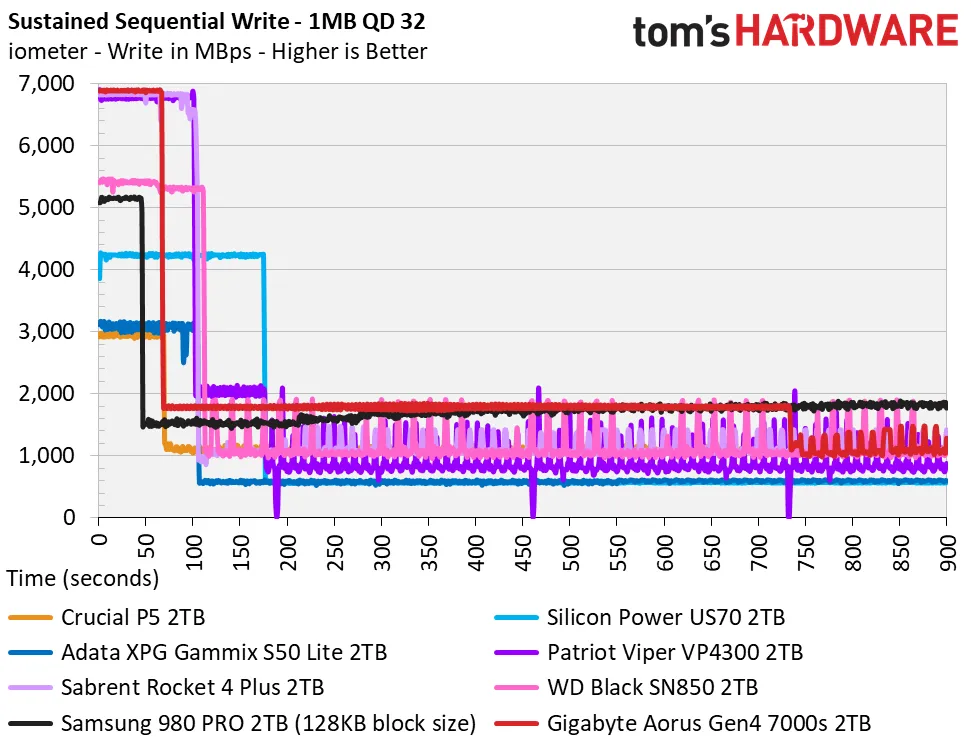

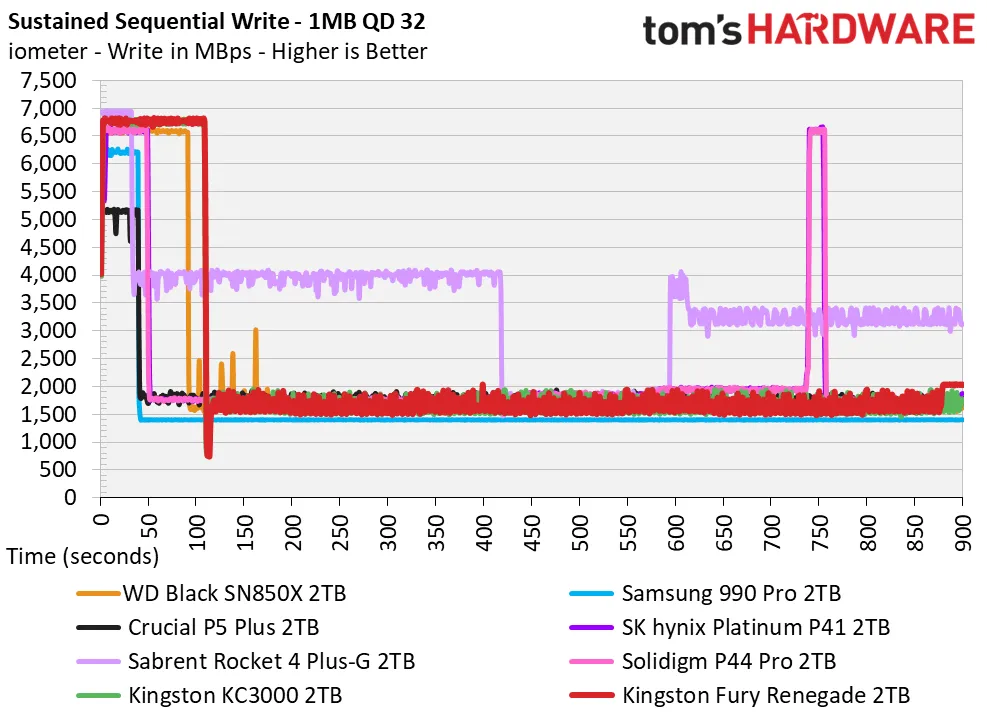

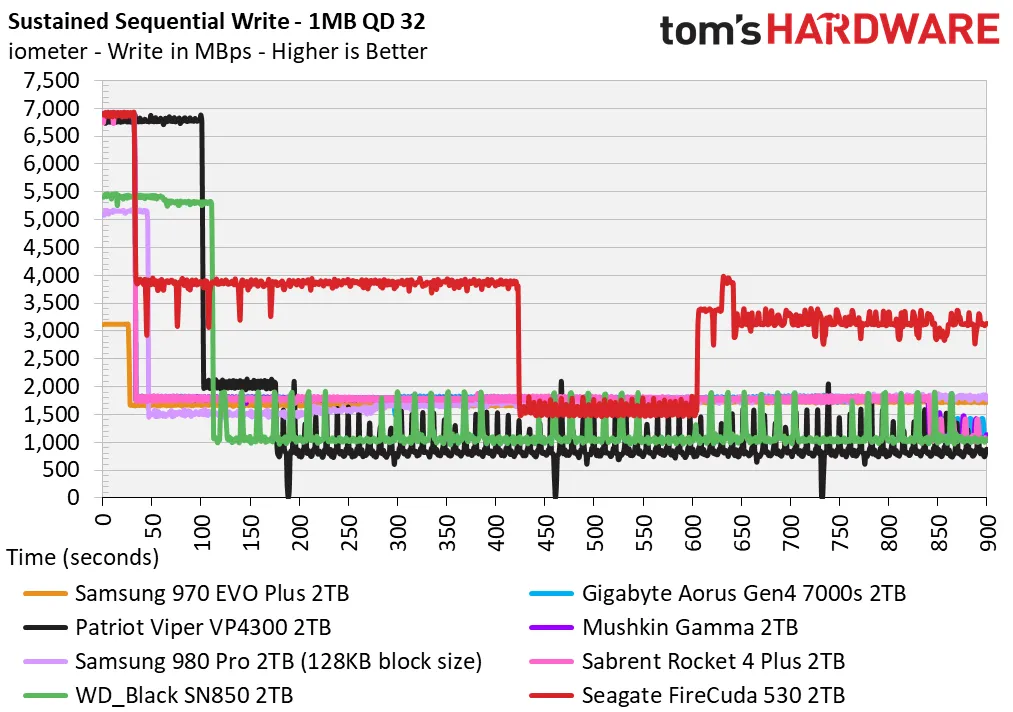

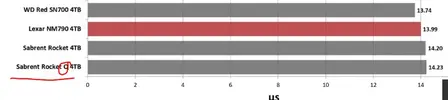

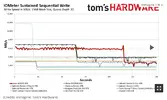

Le Prestazioni di scrittura sostenute e recupero della cache e il consumo energetiche sono quei test più "professionali" che sono per noi utenti difficili da eseguire (ci vuole un software a pagamento, o comunque IOMeter è free ma complicato) e un misuratore che discrimini l'ssd dal resto dell'hardware.

Il test di scrittura sostenuta prende l'ssd e lo riempie progressivamente di blocchi da 1MB fino a saturazione (4TB in questo caso).

LA prima velocità è quella dalla cache pSLC poi dopo un tot di secondi (ricordando sempre che quì l'ssd è vergine) la cache non accoglie più dati e l'ssd inizia a scrivere in TLC e contemporaneamente a svuotare la cache per poter recuperare spazio SLC.

Le tre operazioni contemporanee: scrivere TLC, cancellare la cache, scrivere sulla cache svuotata, determinano un cale consistente della media della scrittura con picchi intermedi che corrispondono a porzioni limitate di scrittura nuovamente sulla cache SLC.

I secondi in cui scrive al massimo, dicono quanto è grande la cache pSLC di scrittura (su ssd vuoto)

In questo caso

120 secondi ad una media di 6000 MB/s sono un bel po di GB.. 700 GB circa.

Vuol dire che da nuovo questo 4TB ha una cache 2100 GB di celle TLC ovvero posso scrivere metà ssd prima che la cache pSLC risenta (cioè si riduca) del riempirsi dei dati.

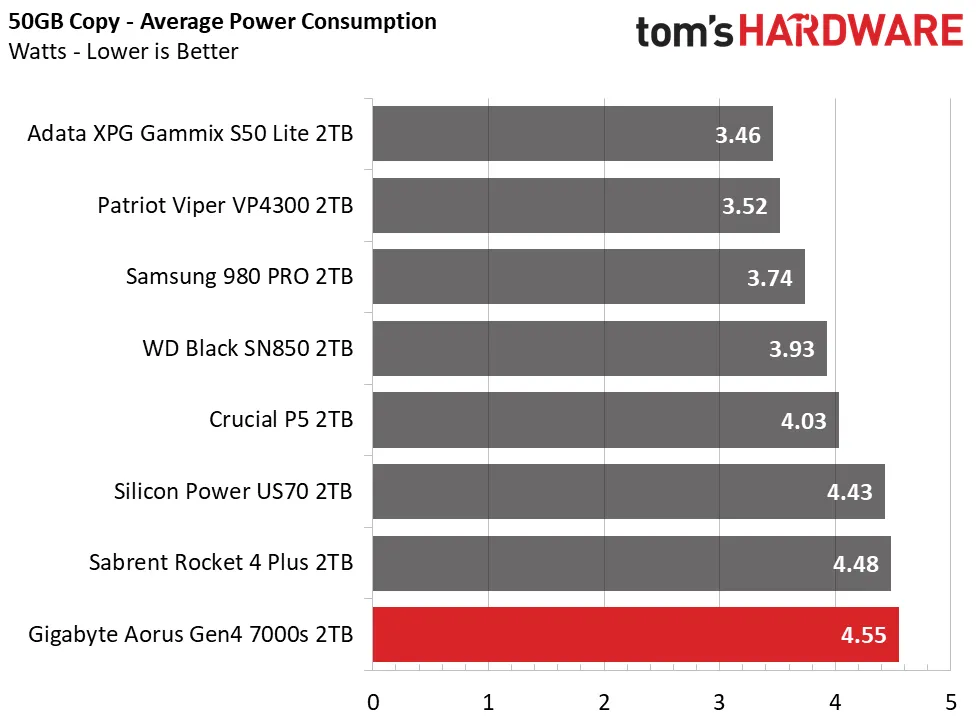

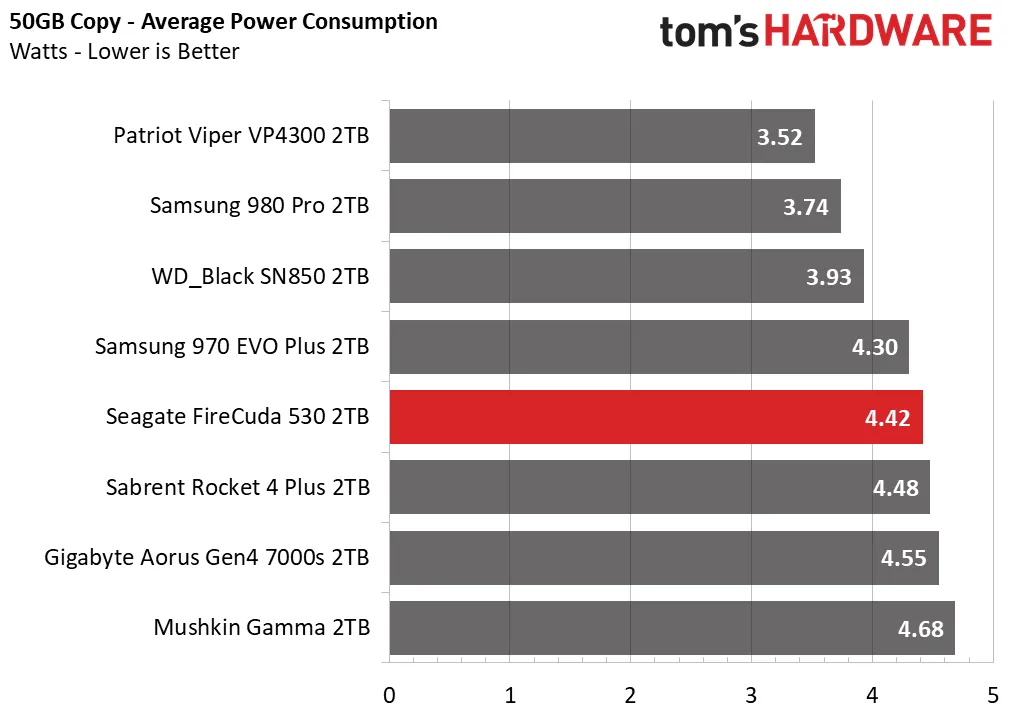

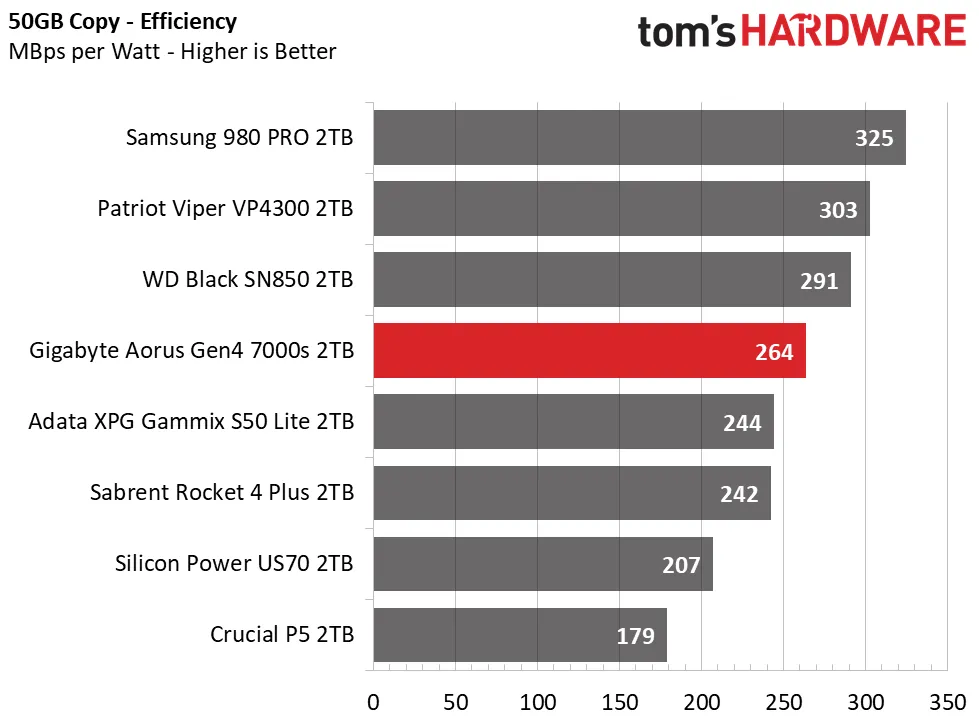

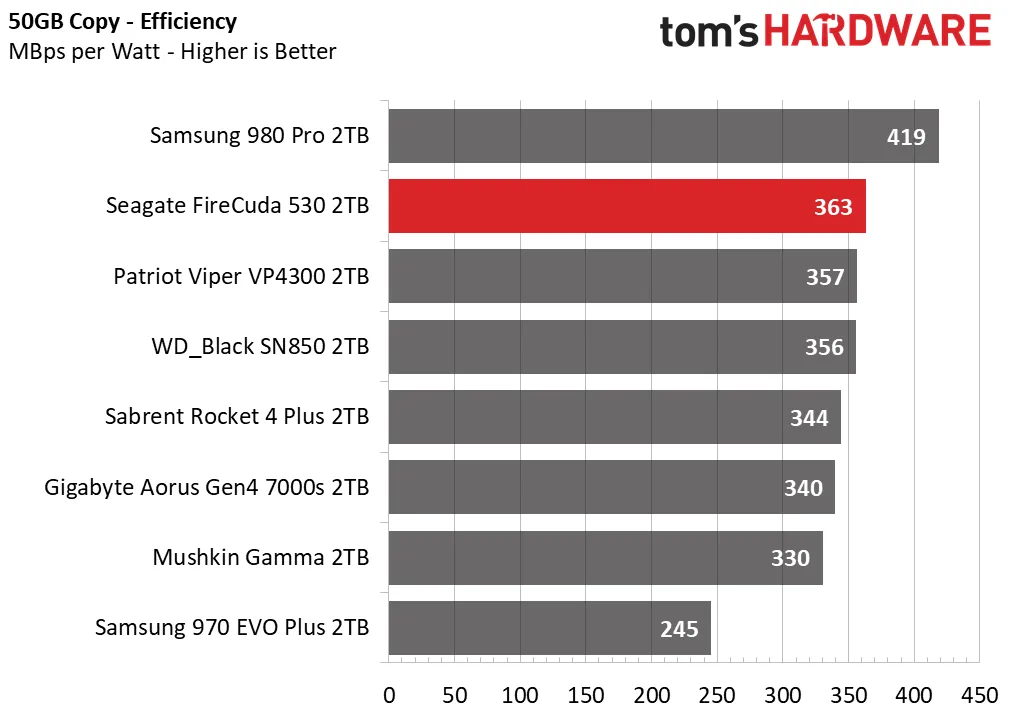

Il test di consumo energetico è e sarà sempre più importante, come qualsiasi CPU anche il controller dovrà nel futuro essere più potente, riducendo il calore.

Il risultato del test:

L'NM790 è incredibilmente efficiente dal punto di vista energetico. Questo è solo uno dei motivi per cui c'è stata così tanta attesa per unità più veloci e senza DRAM nello spazio 4.0. Puoi ottenere prestazioni di fascia alta con grande efficienza ed è ottimo anche per i laptop, soprattutto perché è monofacciale. La flash più densa aiuta anche ad aumentare la capacità, il che rende l'intero pacchetto ancora più attraente se ha il prezzo giusto.

Un minor consumo di energia di solito si traduce anche in temperature più basse. L'NM790 ha raggiunto il picco sotto i 70 °C nei nostri test, ben al di fuori dell'intervallo di temperatura critica. Dovrebbe funzionare alla grande nei laptop e ottenere 4 TB senza ricorrere a QLC è una vittoria enorme per quel segmento.

dice tutto.