sospensioni

Utente Èlite

- Messaggi

- 2,435

- Reazioni

- 549

- Punteggio

- 126

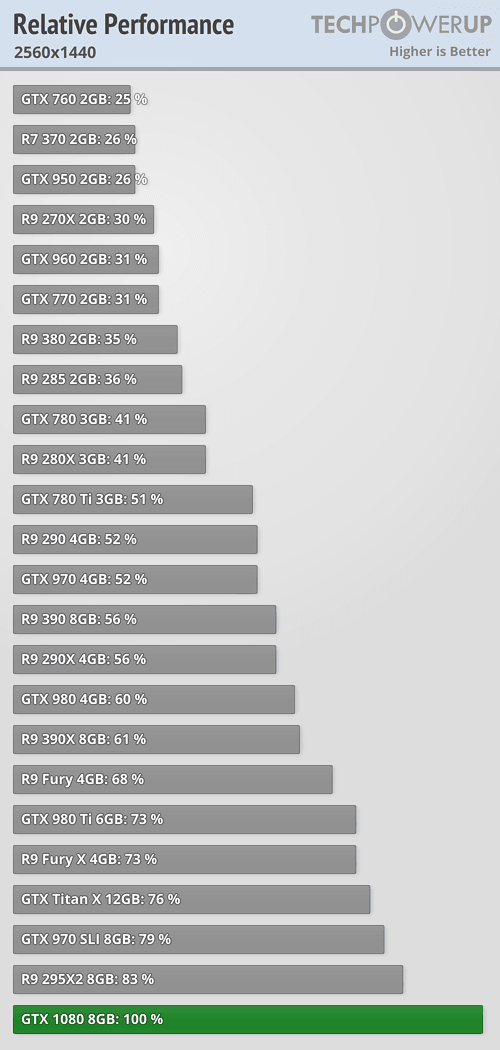

secondo me si piazza sul 77-78%una 980ti a 1190mhz sviluppa 6.7 Tflops

una 1070 a 1750 mhz sviluppa 6.7 tflops

come potenza computazionale sono identiche, senza contare alcune migliorie di pascal rispetto a maxwell

inoltre da gtx 980ti a 1080 corre un +37%, ora per credere a quello che tu dici, gtx 1080 dovrebbe staccare gtx 1070 del 40%...

impossibile/

gtx 1070 sarà più veloce di 980ti, di poco, ma più veloce