Tidusquall

Nuovo Utente

- Messaggi

- 11

- Reazioni

- 4

- Punteggio

- 24

Buongiorno,

cerco di esporre la domanda nel modo più chiaro possibile.

La consegna dell'esercizio è la seguente:

Il codice funziona (allego progetto), ma la mia perplessità è un altra: i tempi di esecuzione.

Per avere dei risultati più attendibili, eseguo 10000 cicli e calcolo la media dei tempi di esecuzione ma i risultati non mi convincono molto.

Come è possibile che tra i risultati mono e multi ci sia una differenza di quasi il 10% in più?

Le chiamate che faccio al kernel sono sia in mono che multi, ed i tempi risultano essere questi:

Comprendo che ci debba essere una differenza tra mono e multi, ma addirittura nell'ultimo output siamo a 0.5 ms in più, non capisco.

cerco di esporre la domanda nel modo più chiaro possibile.

La consegna dell'esercizio è la seguente:

Calcolare la sommatoria di una riga di una matrice con i seguenti parametri:

- N righe, con N = n°blocchi * n°thread

- X colonne

il risultato è un array di N elementi contenente le sommatorie di ogni riga

Il codice funziona (allego progetto), ma la mia perplessità è un altra: i tempi di esecuzione.

Per avere dei risultati più attendibili, eseguo 10000 cicli e calcolo la media dei tempi di esecuzione ma i risultati non mi convincono molto.

Come è possibile che tra i risultati mono e multi ci sia una differenza di quasi il 10% in più?

Le chiamate che faccio al kernel sono sia in mono che multi, ed i tempi risultano essere questi:

####################

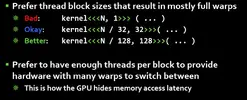

MONO: 8 - 8 MULTI: 4x2 - 4x2

Time Mono: 0.117128 (ms) Time Multi: 0.094554 (ms)

MONO: 16 - 16 MULTI: 4x4 - 4x4

Time Mono: 0.206620 (ms) Time Multi: 0.193303 (ms)

MONO: 32 - 16 MULTI: 8x4 - 4x4

Time Mono: 0.220927 (ms) Time Multi: 0.204934 (ms)

MONO: 16 - 32 MULTI: 4x4 - 8x4

Time Mono: 0.300701 (ms) Time Multi: 0.274282 (ms)

MONO: 16 - 32 MULTI: 4x4 - 4x8

Time Mono: 0.300746 (ms) Time Multi: 0.274242 (ms)

MONO: 64 - 32 MULTI: 8x8 - 8x4

Time Mono: 0.562803 (ms) Time Multi: 0.453662 (ms)

MONO: 64 - 64 MULTI: 8x8 - 8x8

Time Mono: 1.346480 (ms) Time Multi: 0.874964 (ms)

Comprendo che ci debba essere una differenza tra mono e multi, ma addirittura nell'ultimo output siamo a 0.5 ms in più, non capisco.

Ultima modifica: