Ho ripristinato un altro backup di circa 150gb sempre dal vecchio disco sata 2.

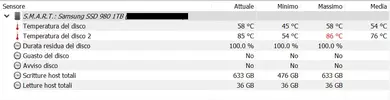

Il 980 si è comportato in questa maniera: facendo riferimento alla temperatura del controller, si è partiti da 54° in idle per poi schizzare a 86° nell'arco di appena 3 minuti (Hwinfo segna in rosso questo valore).

Dopo 9 minuti la temperatura crolla a 63° per poi arrivare dopo 12 minuti a 70°, dopo circa 17 minuti è a 75°, dopo 20 minuti è a 77°, dopo 23 minuti è a 78°, dopo 26 minuti scende a 75°, dopo 30 minuti si rialza a 81°, dopo 33 minuti scende a 79°, dopo 36 minuti scende a 80°, dopo 40 minuti scende a 79°, dopo 43 minuti sale a 80°, dopo 50 minuti sale a 85° ma HWinfo non lo evidenzia ancora in rosso e dopo un paio di minuti il backup è concluso.

Mi sembra di capire che a 86° il 980 va in TT, la temperatura all'improvviso cala drasticamente a 63° per poi lentamente arrivare, tra salite e discese varie, a 85° dopo 50 minuti di lavoro.

Il 980 si è comportato in questa maniera: facendo riferimento alla temperatura del controller, si è partiti da 54° in idle per poi schizzare a 86° nell'arco di appena 3 minuti (Hwinfo segna in rosso questo valore).

Dopo 9 minuti la temperatura crolla a 63° per poi arrivare dopo 12 minuti a 70°, dopo circa 17 minuti è a 75°, dopo 20 minuti è a 77°, dopo 23 minuti è a 78°, dopo 26 minuti scende a 75°, dopo 30 minuti si rialza a 81°, dopo 33 minuti scende a 79°, dopo 36 minuti scende a 80°, dopo 40 minuti scende a 79°, dopo 43 minuti sale a 80°, dopo 50 minuti sale a 85° ma HWinfo non lo evidenzia ancora in rosso e dopo un paio di minuti il backup è concluso.

Mi sembra di capire che a 86° il 980 va in TT, la temperatura all'improvviso cala drasticamente a 63° per poi lentamente arrivare, tra salite e discese varie, a 85° dopo 50 minuti di lavoro.