Si, purtroppo è vero. Usa (l'AI) l'accondiscendenza ai propositi dell'interlocutore partendo da nozioni base giuste (come in questo caso il fatto che la lettura 4K 1QD ha la sua importanza nella rapidità o latenza di un OS) per generalizzare in ragionamenti generalisti e conclusioni che perdono il senso della misura (...allora l'ssd con il 4K in lettura più alto è il migliore).

Se

@aluking ti fossi fermato al primo post

ti avrei detto: si in un certo senso hai ragione, anche se

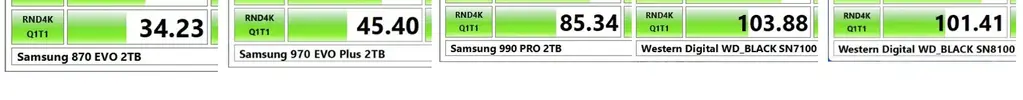

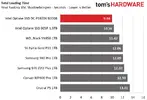

1) confronti un ssd mediocre (Samsung 9100) con uno dei migliori ssd in circolazione (WD SN8100) anzi stiamo parlando di ssd che fanno la differenza.

2) trascuri i limiti tecnologici delle celle ma soprattutto i pareri di chi questi ssd li ha confrontati realmente per cui al di la dei numeri, le prestazioni reali non sono un "abisso" anzi, molti ssd mediocri poi hanno prestazioni reali indistinguibili (per altri aspetti).

Io ho sempre sostenuto che le prestazioni 4K a QD basse sono molto importanti per un ssd.

Non me lo sono potuto permettere ma avrei volentieri preso un ssd Optane giusto perchè massimizzando questo aspetto rende un sistema operativo installato sopra, parecchio più veloce.

L'errore più grande è però stato affidarti alla AI e non sviluppare quello che è stata un opinione di "uso" non di prestazioni, che ti ha contrapposto Black.

Tu hai detto che in un ssd bisogna non guardare le prestazioni sequenziali (che sono marketing, scrivi) e di guardare le prestazioni

perchè il 90% delle operazioni reali su un PC" sono queste.

Ma Black non ti stà dicendo che sbagli, ti dice (in contrapposizione al tuo "parere"...non dati), che l'utente medio noterà poco o niente il vantaggio dato dal 4K ramdonico, perchè le differenze di velocità reali, colte da un utente, in latenza, sono trascurabili (e lo dice chi li ha provati realmente), MENTRE la differenza di velocità sequenziale tra questi ssd, specie di diversa generazione pcie, si colgono eccome nei trasferimenti sequenziali. Allora, ti scrive che, considerare migliore un ssd nvme che fà 95MB/S in casuale rispetto ad uno che ne fà 70(MB/s) non sarebbe poi un punto di preferenza assoluta nel mondo d'uso reale.

Tutto quì ciò che ti è stato detto... ripeto, come PARERE (ancorché espresso, se segui THW, da una persona che di ssd se ne intende).

In seguito ti sei proprio letteralmente "fatto prendere in giro" dall'intelligenza artificiale che ti ha propinato nozioni corrette e conclusioni sbagliate.

Sei sicuro che un sistema operativo, nel suo uso, nell'aprire software, nell'uso di giochi, usi singoli comandi random da 4KB (QD1-2)?

Questo è realmente così, o è come ce l'hanno semplificata un po troppo i recensori?

Vedi ti mancano le basi che ti avrebbero permesso di mettere in forse quello che ti stava dicendo ChatGPT.

Si vede da questa frase:

L'accesso casuale 4KiB crea una coda o QD che già da dei risultati parecchio più veloci del bench sul singolo comando casuale da 4KiB.

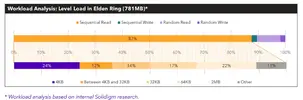

Inoltre il cosiddetto sequenziale classico, pensa che è un file da soli 128 KiB, alcuni software propongono un sequenziale da 1024 KiB, ma se andiamo a vedere il DirectStorage su cui si basa l'accelerazione di caricamento dei giochi fatta per i ssd che hanno prestazioni sequenziali alte, le linee guida raccomandano che le richieste di lettura usino blocchi di almeno 32 KiB.

Capito! 32KiB sono già file sequenziali per Windows.

La frase “4K QD1/QD2 rappresenta lo scenario reale di Windows” è vera… ma solo in parte.

È una semplificazione che i recensori usano per rendere comprensibile un concetto giusto ma più sfumato.

Per capire: Windows genera tantissime operazioni casuali di piccole dimensioni (4–16 KiB).

La maggior parte di queste richieste è fatta da app e servizi che non mettono in coda molte operazioni, quindi QD1–QD4 molto bassa.

Ma In realtà l'imput I/0 reale è molto più vario nell'uso (tolto Windows in quanto OS) e oltre il 50% dei file trasferiti su RAM (letti) dai software utente sono più grandi di 32KiB.

In buona sostanza: dati di partenza giusti / tua conclusione troppo "netta" (non so se mi sono spiegato)

E' quello (importanza del 4K QD1-2) ma... non solo quello, c'è di più e più cose da considerare.

Altra cosa:

Invece il collo di bottiglia è proprio la linea pcie, perchè (MT/s delle celle permettendo) un controller sarebbe molto più veloce per ogni generazione di pcie.

Optane NON è confrontabile (per ovvi motivi).

Chi ha un sistema operativo su nvme forse, e dico forse, lo trova più veloce di un ssa sata ma di sicuro non distinguerebbe un ssd DRAM-less o no, e QLC o no.

L'ssd poi non è un auto soggetta ai limiti di velocità, con gli ssd puoi comprarti il più performante (il Porsche SN8100) ed essere sicuri di avere i trasferimenti più veloci sempre (anche se il costo non vale il tempo guadagnato).

In fondo hai ragione, tanti piccoli file impiegano più tempo a caricarsi di uno solo della stessa dimensione, ma questo non vuol dire che se il 4K di un ssd è più veloce, lo è l'ssd in assoluto.

Come dici, dipende da che uso se ne fà.

Un SN8100 è più veloce nel 4K di tutti gli altri?

Certo!

MA se con un SN850X o un Samsung 990 PRO si spende meno e si ottiene QUASI prestazioni indistinguibili, cosa è meglio consigliare?