Giulio_Splash ha detto:ottimo, grazie per il tuo feedback :)

Prego!

Innanzitutto ho sempre trovato scritto scritture host e sono quelle che secondo me rappresentano le scritture su un SSD.

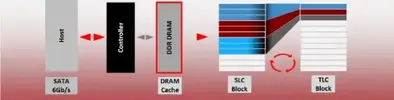

Ma se il Sandisk Extreme PRO riesce a metterci anche le scritture che fa il Garbage Collector (quelle del sistema operativo + quelle interne del controller per intenderci) è una gnignata esagerata perchè allora si tratta delle "vere" scritture sulle NAND.

Confermo che fra i parametri SMART del SanDisk Extreme II e Pro ci sono le scritture effettuate realmente sulle memorie NAND dell'SSD. Questo permette di calcolare con precisione ed in ogni momento (anche per un periodo di tempo arbitrario, facendo la differenza fra valore finale e valore iniziale) la write amplification dividendo le scritture NAND per quelle Host.

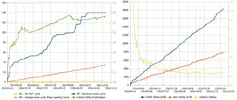

Inoltre sono anche presenti dati curiosi come il numero di cicli di scrittura scritture minimo e massimo effettuato sui blocchi di memoria presenti nell'SSD, in aggiunta a quello medio (che su altri SSD è chiamato Wear Leveling Count), cosa che fa un po' di luce sul modo in cui questi SSD si gestiscono internamente le operazioni di wear leveling.

Con questi parametri si possono monitorare nel corso del tempo come si evolve l'usura dell'SSD con più dettaglio rispetto al solito. Ad esempio io ho tracciato questo grafico del mio:

C'è la possibilità che sia stato un bad block sfuggito ai controlli di fabbrica di cui l'SSD se ne è accorto quando si è andati ad utilizzarlo. Se non ne appaiono altri dopo che è stato effettuato un ammontare di scritture NAND almeno pari a quella della capienza dell'SSD, è ragionevole pensare che sia stato questo il caso e che dunque si può stare tranquilli.Ciò che mi lascia basito è che vengano segnalati dei ehm... problemi...che, ti tranquillizzo, assolutamente sono ininfluenti e non influiscono in nessun modo sulle prestazioni.

I dati proccupanti che osservo sono l'ID 5/05 171/AB 212/D4 232/E8

Piuttosto, quel SATA PHY error sembra essere sintomo di un problema di comunicazione fra SSD e Host SATA, magari è il cavo SATA usato.